Разработка поисковой системы требует глубокого понимания принципов работы с данными, алгоритмами и масштабируемыми технологиями. Основным элементом поисковика является индексатор, который анализирует и хранит информацию о страницах Интернета. Сначала нужно разработать структуру для хранения данных, используя базы данных, такие как Elasticsearch или Apache Solr, которые обеспечивают эффективный поиск по индексам.

Алгоритм ранжирования результатов поиска – один из ключевых аспектов работы поисковой системы. Важно учитывать не только точность, но и релевантность запросов. Современные поисковики применяют различные методы, включая PageRank, TF-IDF и нейросетевые модели, чтобы предложить пользователю наиболее подходящие страницы. Важно протестировать алгоритм на различных типах запросов для понимания, как система реагирует на разные параметры поиска.

Для масштабируемости системы стоит использовать распределённые вычисления, например, через Hadoop или Spark. Эти фреймворки позволяют эффективно обрабатывать большие объемы данных в реальном времени. Кроме того, для обеспечения быстродействия поисковик должен поддерживать кэширование, использующее Redis или Memcached, что снижает нагрузку на серверы при повторных запросах.

Наконец, стоит учесть аспект безопасности поисковой системы. Для этого важно внедрить защиту от спама и манипуляций с результатами поиска, использовать методы для предотвращения DDoS-атак и регулярно обновлять алгоритмы для борьбы с нечестными SEO-методами.

Как выбрать архитектуру для поисковой системы

При создании поисковой системы выбор архитектуры – один из наиболее важных этапов. Это определяет, как будут храниться и обрабатываться данные, а также как быстро и эффективно пользователи смогут получать результаты поиска. Важно учитывать несколько факторов при принятии решения о структуре системы.

1. Масштабируемость – поисковая система должна быть готова к росту объема данных и увеличению числа пользователей. Для этого важно проектировать архитектуру с возможностью горизонтального масштабирования, то есть добавления новых серверов по мере необходимости. Подходы, такие как шардирование данных, могут быть полезны для распределения нагрузки между несколькими серверами и улучшения производительности.

2. Производительность – поисковая система должна обеспечивать быстрый отклик на запросы пользователей, даже при большом объеме данных. Для этого можно использовать кеширование на уровне запросов и результатов поиска, а также оптимизацию индексов, что позволяет ускорить процесс поиска.

3. Разделение данных и индексов – данные и индексы должны храниться отдельно, что облегчает их обновление и оптимизацию. Индексы должны быть структурированы для быстрого поиска, что требует тщательной разработки алгоритмов для индексации и хранения данных. Использование таких технологий, как Elasticsearch или Apache Solr, может значительно ускорить процесс поиска.

4. Сетевые и распределенные компоненты – для обеспечения надежности системы важно использовать распределенную архитектуру. Это позволяет избежать единой точки отказа и обеспечивает отказоустойчивость. Кластеры серверов должны быть настроены таким образом, чтобы автоматически перенаправлять трафик при отказе одного из серверов.

5. Реализация поиска в реальном времени – важно обеспечить быструю индексацию новых данных. Для этого можно использовать такие решения, как индексация в реальном времени, где данные сразу после их добавления становятся доступными для поиска. Однако это требует дополнительных вычислительных мощностей и оптимизации процессов обработки данных.

6. Безопасность – поисковая система должна быть защищена от несанкционированного доступа, атак и потери данных. Важно внедрять системы аутентификации и авторизации, а также шифрование данных как при хранении, так и при передаче через сеть.

7. Обработка запросов и алгоритмы – архитектура должна учитывать сложность запросов, которые будут обрабатываться системой. Это включает в себя поддержку полнотекстового поиска, работы с синонимами, обработку ошибок в запросах и фильтрацию контента. Важно также поддерживать алгоритмы ранжирования для того, чтобы пользователи получали наиболее релевантные результаты.

8. Технологии хранения – выбор базы данных зависит от конкретных требований к скорости и объему данных. Для индексирования часто используется NoSQL базы данных, такие как Elasticsearch или Apache Cassandra, которые обеспечивают высокую производительность при хранении больших объемов неструктурированных данных.

В итоге, выбор архитектуры поисковой системы зависит от множества факторов, включая требования к масштабируемости, производительности и безопасности. Важно создать систему, способную эффективно справляться с ростом объемов данных и запросов пользователей, при этом обеспечивая быстрое время отклика и высокую точность поиска.

Что нужно для сбора и хранения данных для индексации

После того как данные собраны, возникает необходимость в их хранении. Один из самых распространенных подходов – использование распределенных систем хранения, таких как Hadoop или Apache Cassandra. Это важно для обработки большого объема данных и обеспечения отказоустойчивости. Важно, чтобы система хранения данных обеспечивала быстрый доступ и возможность горизонтального масштабирования.

Для хранения исходных данных, а также метаданных (таких как URL, дата последнего обновления, глубина страницы) обычно используется реляционная база данных (например, MySQL или PostgreSQL). Однако для хранения текстовых данных или больших объемов информации можно воспользоваться NoSQL решениями, такими как MongoDB или Elasticsearch.

Для индексации данных потребуется структурировать информацию. Тексты с веб-страниц могут быть преобразованы в ключевые слова и мета-данные, которые позволяют быстрого поиска и фильтрации информации. Для этого применяются алгоритмы обработки текста, такие как токенизация, лемматизация и стемминг. Алгоритмы должны учитывать тип контента (например, текст, изображения, видео), а также частоту запросов, чтобы данные можно было индексировать наиболее эффективно.

Также необходимо установить систему для регулярного обновления данных в индексе. Для этого можно использовать cron-задания или другие методы автоматического обновления, чтобы постоянно поддерживать актуальность информации.

Важно учитывать безопасность данных. Применение SSL для шифрования трафика между серверами, а также регулярные проверки на наличие уязвимостей в системе хранения и сбора данных помогут защитить ваши ресурсы от атак и утечек информации.

Как спроектировать алгоритм поиска и ранжирования

Алгоритм поиска и ранжирования – ключевая часть поисковой системы. Он отвечает за то, как быстро и точно система находит релевантные результаты, оценивает их качество и формирует итоговый список. Процесс проектирования алгоритма включает несколько важных этапов: анализ запроса, индексация контента, вычисление релевантности и окончательное ранжирование.

Первоначально важно создать структуру данных для хранения индекса. Обычно используется инвертированный индекс – структура, где каждому слову из документа сопоставляется список всех его вхождений в тексте. Это позволяет быстро находить документы по ключевым словам. Важной частью является также создание синонимов и обработка ошибок ввода (например, опечаток), что повышает точность поиска.

После создания индекса необходимо сосредоточиться на ранжировании. Ранжирование – это процесс оценки, насколько найденные документы соответствуют запросу. Простой способ – использовать частоту появления ключевых слов в тексте (TF-IDF). Однако в реальных поисковых системах этот метод не всегда достаточен, так как не учитывает контекст и важность источников информации.

Для повышения точности используется более сложный подход: анализ ссылок между страницами (например, алгоритм PageRank). Он оценивает, сколько и какие страницы ссылаются на документ, что позволяет определить его авторитетность. Кроме того, следует учитывать такие факторы, как мета-теги, заголовки, качество текста и поведение пользователей на сайте (например, время нахождения на странице, клики).

Чтобы улучшить ранжирование, необходимо внедрить дополнительные механизмы, такие как машинное обучение. Современные поисковые системы используют модели, обученные на большом объеме данных, для предсказания релевантности документа на основе множества факторов. Для этого можно использовать методы классификации и регрессии, а также нейронные сети, способные анализировать не только текст, но и изображения, видео и другие типы данных.

Особое внимание стоит уделить анализу семантики запроса. Современные алгоритмы должны уметь распознавать не только точные совпадения, но и смысловые связи между словами. В этом помогут технологии NLP (обработка естественного языка), которые позволяют учитывать синонимы, омонимы и контекстные связи.

Не стоит забывать и о скорости работы поисковой системы. Алгоритмы должны быть оптимизированы для быстрого поиска и ранжирования, особенно когда речь идет о миллионах документов. Для этого важно использовать эффективные алгоритмы поиска, кэширование результатов, параллельные вычисления и распределенные системы хранения данных.

Наконец, для тестирования и улучшения алгоритмов необходимо собирать и анализировать обратную связь от пользователей. Анализ их поведения, кликов и статистики поисковых запросов поможет точнее настроить ранжирование и повысить качество результатов.

Как настроить и реализовать систему обновления индекса

Для успешной работы поисковой системы необходимо обеспечить актуальность индекса. Система обновления индекса должна быть быстро настроена, эффективно работать и учитывать динамичные изменения на веб-страницах. Это обеспечивается через использование механизмов инкрементального обновления, планирования задач и обработки ошибок.

Первый шаг – определение частоты обновления. Для сайтов с высоким обновлением контента (новости, социальные сети) индексация должна происходить часто, например, раз в несколько минут. Для более стабильных ресурсов, таких как корпоративные страницы или блоги, достаточно обновлений раз в несколько дней. Планирование должно учитывать нагрузку на сервер и ресурсы, доступные для выполнения индексации.

Далее важно настроить механизм инкрементального обновления, который позволяет индексировать только изменившиеся страницы. Это ускоряет процесс и снижает нагрузку. Для этого используется сравнение текущего состояния страницы с предыдущей версией. Если контент изменился, происходит его переиндексация. Важно хранить хеши страниц или их метаданные для быстрой идентификации изменений.

Для эффективной работы системы необходимо реализовать очередь задач, которая будет управлять процессом обновления. Очередь задач позволяет избежать перегрузки и контролировать приоритеты индексации. Это важно для сайтов с большими объемами данных, где обновление одного элемента не должно блокировать работу с другими.

Использование событийных триггеров помогает ускорить процесс обновления индекса. Например, можно настроить систему так, чтобы при изменении контента на сайте автоматически запускался процесс переиндексации. Это позволяет оперативно реагировать на изменения и обеспечивать актуальность индекса без задержек.

Важным аспектом является обработка ошибок, которые могут возникать в процессе обновления. Нужно заранее предусмотреть систему повторных попыток индексации, а также уведомления о сбоях. Это обеспечит бесперебойную работу системы, даже если возникнут временные проблемы с доступностью контента.

Для дополнительного ускорения процесса обновления индекса можно настроить параллельную индексацию, разбив процесс на несколько потоков или серверов. Это особенно важно при работе с большими объемами данных, когда нужно индексировать сотни или тысячи страниц одновременно.

Какие методы обработки запросов пользователей выбрать

При создании поисковой системы важно правильно выбрать методы обработки запросов пользователей. Это определяет, насколько эффективно система будет извлекать релевантную информацию. Рассмотрим несколько ключевых методов:

- Токенизация – процесс разбиения текста запроса на отдельные элементы (токены). Это позволяет системе понять структуру запроса, выделить важные ключевые слова. Для русского языка важна корректная обработка склонений и форм слов. Например, «автомобиль» и «автомобили» должны восприниматься как одно слово.

- Нормализация – приведение слов к базовой форме. Например, из формы «читающих» система должна извлечь корень «читать». Для эффективной нормализации лучше использовать морфологический анализатор, учитывающий особенности языка.

- Поиск с учетом синонимов и семантики – использование синонимов позволяет улучшить точность поиска. Важно, чтобы поисковая система не ограничивалась только точными совпадениями, а умела учитывать контекст. Это достигается с помощью семантического поиска, например, через модели на основе машинного обучения или word2vec.

- Индексирование – правильная организация индексов имеет решающее значение. Для быстрого поиска полезно использовать инвертированные индексы, которые связывают ключевые слова с документами. Это сокращает время на обработку запросов.

- Кластеризация – метод, при котором запросы пользователей группируются по схожести. Это помогает отфильтровать нерелевантные результаты и представить пользователю наиболее близкие по смыслу страницы. Важно учитывать тонкие различия между запросами, чтобы избежать ошибок при группировке.

- Фильтрация по релевантности – система должна учитывать не только наличие ключевых слов, но и их важность для запроса. Для этого часто используется оценка веса терминов через алгоритм TF-IDF (Term Frequency-Inverse Document Frequency). Также можно интегрировать пользовательские предпочтения для точности поиска.

Эти методы можно комбинировать для создания более точной и адаптивной поисковой системы. Важно тестировать каждый метод на практике, чтобы адаптировать их под конкретные задачи и улучшать качество поиска.

Как реализовать систему масштабирования поисковой системы

Для реализации масштабируемой поисковой системы нужно решать несколько ключевых задач:

- Распределение нагрузки. Необходимо разработать систему, которая будет эффективно распределять запросы между несколькими серверами. Это можно сделать с помощью балансировщиков нагрузки, которые направляют трафик на наиболее доступные узлы.

- Разделение индексации. Для масштабируемости важно разделить индекс на несколько частей (шардов). Каждая часть будет храниться на отдельном сервере или кластере серверов. При этом стоит использовать механизмы, которые позволяют быстро находить нужные данные среди всех шардов, например, Consistent Hashing.

- Использование кэширования. Для уменьшения нагрузки на базу данных и ускорения обработки запросов можно использовать кэширование. Важно правильно настроить кэширование как на уровне веб-сервера, так и на уровне базы данных, чтобы избежать излишних повторных запросов.

- Многопоточность и асинхронность. Использование многопоточности и асинхронных операций позволяет эффективно обрабатывать множество запросов одновременно, снижая задержки и повышая общую производительность.

- Оптимизация запросов. Важно тщательно оптимизировать как поисковые запросы, так и алгоритмы индексации. Для этого можно использовать методы предварительной обработки, такие как токенизация, стемминг и фильтрация стоп-слов, которые помогут снизить нагрузку на систему.

Масштабируемая поисковая система должна также поддерживать динамическое добавление новых серверов и узлов без значительных сбоев в работе. Для этого применяются такие подходы, как автоматическое распределение и перераспределение данных по узлам.

Кроме того, необходимо следить за производительностью системы в реальном времени, используя инструменты мониторинга и логирования. Это позволит вовремя обнаружить узкие места в системе и внести корректировки.

Как интегрировать аналитические инструменты для мониторинга работы поисковика

Интеграция аналитических инструментов в поисковую систему позволяет эффективно отслеживать ее производительность и улучшать качество результатов поиска. Важно использовать такие решения, которые обеспечат полноту данных, быстрое реагирование на изменения и гибкость в настройке. Рассмотрим ключевые моменты интеграции.

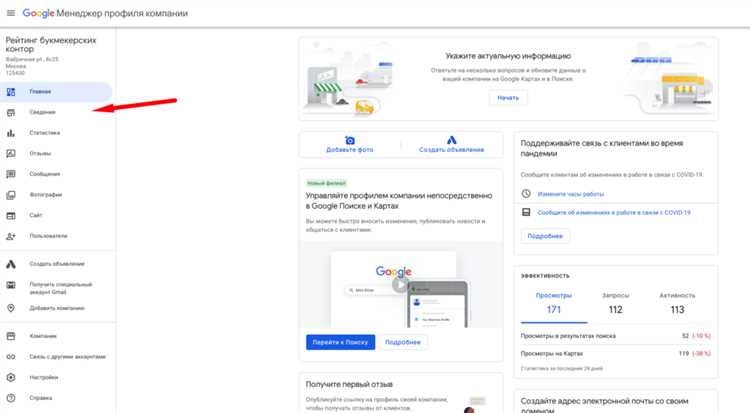

Первым шагом является настройка сбора метрик работы поисковой системы. Для этого можно использовать инструменты, такие как Google Analytics или аналогичные решения с открытым исходным кодом. Важно настроить трекинг ключевых показателей: количество запросов, время отклика поисковика, качество выданных результатов, а также кликабельность каждого результата поиска.

Для более глубокого анализа потребуется интеграция с системами мониторинга производительности, такими как Prometheus или Grafana. Эти инструменты позволяют в реальном времени отслеживать загрузку серверов, обработку запросов, уровень ошибок и другие критичные параметры. Настройка алертов в случае отклонений от нормальных значений поможет оперативно выявлять и устранять проблемы.

Также стоит интегрировать инструменты для анализа логов, такие как ELK Stack (Elasticsearch, Logstash, Kibana). Это позволит собирать и визуализировать данные о запросах пользователей, ошибках системы, а также отслеживать поведение индексов. Логирование является важной частью для диагностики и оптимизации работы поисковика.

Для улучшения качества поиска можно настроить анализ пользовательского поведения через A/B тестирование. Например, можно использовать инструменты, такие как Optimizely или Google Optimize, для тестирования различных алгоритмов ранжирования и оценки их эффективности в реальных условиях. Это даст возможность выбирать лучшие подходы к оптимизации поискового процесса.

Важно интегрировать системы для отслеживания точности поисковых результатов. Использование моделей машинного обучения, таких как модели обучения с подкреплением, позволит корректировать алгоритм ранжирования на основе обратной связи пользователей. Такие системы могут автоматически улучшать результаты поиска, анализируя поведение пользователей и их взаимодействие с результатами поиска.

Не менее важным аспектом является интеграция с инструментами для мониторинга индексации. Решения, такие как Apache Nutch или Scrapy, помогут отслеживать эффективность индексации веб-страниц, проверяя корректность и полноту процесса. Эти инструменты могут выявить страницы, которые не были проиндексированы, или те, которые имеют проблемы с доступностью для поисковой системы.

Подключение всех этих инструментов создаст мощную инфраструктуру для мониторинга и улучшения работы поисковика. Важно, чтобы система была настроена таким образом, чтобы все данные собирались централизованно, что позволит анализировать их в едином контексте и принимать решения на основе комплексной информации.

Вопрос-ответ:

Что нужно для создания поисковой системы с нуля?

Для создания поисковой системы с нуля нужно продумать несколько ключевых этапов. Во-первых, необходима база данных, в которой будет храниться информация о веб-страницах. Для этого нужно создать парсер, который будет сканировать сайты и извлекать текстовую информацию. Далее следует разработать алгоритм поиска, который будет учитывать релевантность, частоту запросов и другие факторы. Также нужно организовать индексацию информации для быстрого поиска по ключевым словам. Важно предусмотреть инфраструктуру для обработки запросов и алгоритмы для ранжирования результатов.

Как парсер собирает информацию о веб-страницах?

Парсер представляет собой программу, которая посещает веб-страницы и извлекает с них данные. В первую очередь он загружает HTML-код страницы, затем анализирует его структуру, извлекает текст, ссылки и другие важные элементы (например, мета-теги). Собранные данные могут быть сохранены в базе данных, чтобы впоследствии использовать их для индексации и поиска. Парсер может быть настроен для работы с различными типами контента, включая текст, изображения, видео и т. д. Процесс сбора информации называется краулингом.

Как работает алгоритм поиска в поисковой системе?

Алгоритм поиска анализирует запрос пользователя и сопоставляет его с индексом, который хранит информацию о веб-страницах. Он использует различные факторы для ранжирования результатов: например, наличие ключевых слов на странице, частоту их упоминания, а также более сложные метрики, такие как синонимы, семантическая близость и качество ссылок. Алгоритм может учитывать и поведение пользователей, например, какие страницы они чаще посещают. Чем точнее поисковый алгоритм может интерпретировать запрос и подобрать релевантную информацию, тем выше качество поиска.

Нужно ли обучать поисковую систему на данных пользователей?

Да, обучать поисковую систему на данных пользователей очень важно для улучшения качества поиска. Используя информацию о том, какие страницы выбирают пользователи, система может адаптировать свои алгоритмы для более точного предсказания того, что будет наиболее полезно для каждого следующего запроса. Это может включать анализ кликов, времени пребывания на страницах, а также отзывов и предпочтений. Регулярное обновление данных и обучение на основе поведения пользователей помогает поисковой системе становиться более эффективной и точной с каждым днем.

Какие проблемы могут возникнуть при создании поисковой системы?

Одной из главных проблем является обеспечение качества индексации. Например, не все страницы могут быть правильно распознаны или проиндексированы, если их структура слишком сложная или они содержат элементы, которые мешают парсерам корректно их анализировать. Также существует проблема обработки больших объемов данных — поисковой системе нужно эффективно работать с миллиардами страниц, что требует наличия мощной инфраструктуры. Другой вызов — это разработка алгоритмов поиска, которые могут адекватно оценивать качество информации и избегать манипуляций с результатами (например, спама или некорректных ссылок). Регулярная настройка и оптимизация этих процессов также является важной частью работы поисковой системы.

Какие этапы необходимы для создания поисковой системы с нуля?

Создание поисковой системы с нуля включает несколько ключевых этапов. Во-первых, нужно спроектировать и построить структуру для сбора и обработки данных. Это требует написания краулеров для сбора информации с веб-сайтов и создания индекса, который позволит быстро находить нужные страницы. Затем необходимо разработать алгоритм ранжирования, который будет определять, какие страницы должны отображаться в результатах поиска. Это включает в себя работу с метками, ключевыми словами и поведением пользователей. После этого важно протестировать систему, чтобы убедиться, что результаты поиска соответствуют ожиданиям. На последнем этапе следует оптимизировать производительность и внедрить механизмы защиты от спама и манипуляций с результатами.

Какие основные сложности могут возникнуть при создании поисковой системы с нуля?

Основные сложности, с которыми можно столкнуться при создании поисковой системы, включают технические проблемы с обработкой больших объемов данных, а также с обеспечением высокой скорости работы системы. Важно правильно настроить систему индексации, чтобы она могла быстро и эффективно обрабатывать информацию с большого числа сайтов. Еще одна проблема — это разработка алгоритма ранжирования, который должен учитывать множество факторов: от качества контента до актуальности страниц. Также необходимо бороться с попытками манипуляций с результатами поиска, такими как спам или черные методы SEO. Кроме того, важно обеспечить масштабируемость системы, чтобы она могла поддерживать растущие объемы данных.