Формат TXT используется для хранения структурированных и неструктурированных данных в текстовом виде. Несмотря на простоту, он часто применяется при экспорте логов, отчетов или промежуточных данных из различных систем. Задача переноса таких данных в базу данных SQL требует четкого понимания структуры файла, особенностей кодировки и формата разделителей.

Перед импортом необходимо определить схему таблицы: количество столбцов, типы данных, ограничения. Например, если в TXT-файле содержатся значения, разделённые табуляцией, каждое поле должно быть сопоставлено соответствующему столбцу SQL-таблицы. Важно учесть возможные пустые строки, пробелы в конце строк, некорректные символы и дубликаты.

Рекомендуется использовать утилиту BULK INSERT в SQL Server или команду LOAD DATA INFILE в MySQL для загрузки больших объёмов данных. При этом необходимо явно указать кодировку файла (например, UTF-8) и задать параметры разделителей. Дополнительно можно задействовать временную таблицу для предварительной загрузки и очистки данных перед окончательным импортом в основную таблицу.

Если структура файла нестабильна или содержит вложенные элементы, целесообразно использовать скрипты на Python или PowerShell для предварительной обработки данных. Это позволяет автоматизировать удаление лишних символов, нормализацию форматов дат, а также логирование ошибок при импорте.

Определение структуры таблицы базы данных перед импортом

Перед импортом данных из TXT-файла необходимо точно определить схему таблицы назначения. Структура должна отражать формат и типы данных каждого столбца в исходном файле. Ошибки на этом этапе приводят к потерям данных, нарушению целостности и сбоям при вставке.

Шаг 1: Анализ содержимого файла. Откройте файл в текстовом редакторе или средстве просмотра. Убедитесь, что разделители (например, табуляция, запятая, точка с запятой) единообразны. Проверьте наличие заголовков столбцов и определите примерные типы значений – числовые, текстовые, даты.

Шаг 2: Определение типов данных. Для каждого поля установите подходящий тип: INT – для целых чисел, DECIMAL – для чисел с плавающей точкой, VARCHAR(n) – для строк фиксированной длины, DATE или DATETIME – для даты и времени. Учитывайте максимальную длину строк и формат дат.

Шаг 3: Учет обязательных и уникальных значений. Если в TXT-файле есть поля, которые всегда заполнены, присваивайте им атрибут NOT NULL. Для идентификаторов и ключевых полей рассмотрите применение PRIMARY KEY или UNIQUE.

Шаг 4: Подготовка команды CREATE TABLE. На основе анализа составьте SQL-скрипт создания таблицы. Пример:

CREATE TABLE ИмяТаблицы (ID INT PRIMARY KEY, Name VARCHAR(100), Price DECIMAL(10,2), CreatedAt DATETIME NOT NULL);

После создания структуры таблицы можно переходить к подготовке скрипта импорта данных с учетом сопоставления колонок и корректного преобразования типов.

Выбор подходящего формата хранения данных в TXT-файле

Перед импортом данных из TXT-файла в базу данных SQL необходимо определить структуру, которая обеспечит надёжность парсинга и минимизирует ошибки при передаче информации.

- Разделитель: Используйте однозначный символ, не встречающийся в данных. Наиболее надёжны – табуляция (

\t) или вертикальная черта (|). Запятая и точка с запятой часто встречаются в текстовых значениях, что увеличивает риск некорректного разбора. - Кодировка: Применяйте UTF-8 без BOM, особенно при работе с многоязычными данными. Это обеспечит корректную интерпретацию символов и совместимость с большинством СУБД.

- Формат строк: Каждая строка должна соответствовать одной записи. Исключите пустые строки и неполные данные. При необходимости – проверка длины строки или числа столбцов до импорта.

- Экранирование: Если данные содержат символы-разделители, оборачивайте значения в кавычки (обычно двойные). Внутри значений кавычки должны дублироваться. Пример:

"Иван ""Петров""". - Формат чисел и дат: Используйте ISO 8601 для дат (

YYYY-MM-DD) и точку в качестве десятичного разделителя. Это упростит автоматическую обработку. - Последовательность столбцов: Должна строго соответствовать структуре целевой таблицы. Любые отклонения приведут к ошибкам при импорте или неверному сопоставлению данных.

Грамотно структурированный TXT-файл позволяет избежать необходимости в сложной предварительной обработке и повышает надёжность переноса в SQL-базу.

Использование BULK INSERT для загрузки данных в SQL Server

Для использования BULK INSERT требуется наличие файла данных на сервере или в доступной для него сетевой папке. Файл должен быть в кодировке, соответствующей настройкам SQL Server, чаще всего – UTF-8 или ANSI. Разделители полей и строк задаются параметрами FIELDTERMINATOR и ROWTERMINATOR.

Пример базового синтаксиса:

BULK INSERT dbo.ИмяТаблицы FROM 'C:\путь\к\файлу.txt' WITH ( FIELDTERMINATOR = ';', ROWTERMINATOR = '\n', FIRSTROW = 2, CODEPAGE = '65001' )

Параметр FIRSTROW указывает, с какой строки начинать импорт, что полезно при наличии заголовков. CODEPAGE управляет интерпретацией символов: 65001 означает UTF-8, 1251 – Windows-1251.

Перед импортом убедитесь, что структура таблицы полностью соответствует формату данных в файле: количество и порядок столбцов, типы данных, допустимые значения. При несовпадении загрузка завершится с ошибкой, либо строки будут частично импортированы, если не задан параметр ERRORFILE для логирования проблемных записей.

Для повышения надёжности рекомендуется временно отключать ограничения (например, FOREIGN KEY) и триггеры, а также использовать транзакции, чтобы откатить загрузку при ошибке:

BEGIN TRANSACTION; BEGIN TRY BULK INSERT ... COMMIT; END TRY BEGIN CATCH ROLLBACK; THROW; END CATCH

Если файл размещён на другом сервере, потребуется задать SHARE с разрешением на чтение и указать полный UNC-путь (например, \\сервер\папка\файл.txt), а также убедиться, что служба SQL Server имеет доступ к этому пути.

BULK INSERT – предпочтительный способ загрузки больших объёмов данных в рамках автоматизированных ETL-процессов или при первичной инициализации базы.

Предварительная очистка и валидация данных из файла

Перед импортом данных из TXT-файла в SQL-базу необходимо устранить ошибки форматирования и проверить корректность значений. Файл должен иметь единый формат кодировки, предпочтительно UTF-8 без BOM, чтобы избежать ошибок при чтении кириллических символов.

Удалите пустые строки, символы табуляции и пробелы в начале и конце каждой строки. Используйте регулярные выражения для удаления недопустимых символов, особенно если данные будут вставляться в поля с ограничениями, например, числовые или датовые типы.

Валидация должна охватывать следующие аспекты:

- Проверка длины строк – строки не должны превышать максимальную длину столбцов в таблице.

- Формат даты – все даты должны быть приведены к формату

YYYY-MM-DD, особенно при работе сDATEиDATETIME. - Числовые значения – заменить запятые на точки, удалить пробелы между цифрами, исключить символы валют.

- Дубликаты – сравнение по ключевым полям с целью исключения повторов.

Для автоматизации очистки используйте скрипты на Python с библиотеками pandas и re, либо PowerShell, если операция выполняется на Windows. После очистки данные необходимо протестировать на выборке, имитируя загрузку в тестовую таблицу с теми же ограничениями, что и у основной.

Создание скрипта на T-SQL для импорта строки за строкой

Для построчного импорта данных из текстового файла используется цикл с функцией OPENROWSET и BULK, настроенный на чтение одной строки за итерацию. Необходима предварительная настройка прав доступа к файлу и включение компонента Ad Hoc Distributed Queries.

Создайте временную таблицу с соответствующей структурой данных, например:

CREATE TABLE #TempImport (Line NVARCHAR(MAX));

Загрузите содержимое файла в таблицу построчно, применяя BULK INSERT с указанием параметра ROWTERMINATOR:

BULK INSERT #TempImport FROM ‘C:\Data\input.txt’ WITH (ROWTERMINATOR = ‘\n’, FIELDTERMINATOR = ‘|||’, CODEPAGE = ‘65001’);

Далее организуйте курсор для обработки каждой строки:

DECLARE line_cursor CURSOR FOR SELECT Line FROM #TempImport;

DECLARE @line NVARCHAR(MAX);

OPEN line_cursor;

FETCH NEXT FROM line_cursor INTO @line;

WHILE @@FETCH_STATUS = 0

BEGIN

— Парсинг строки, например с использованием STRING_SPLIT или CHARINDEX

— Вставка в основную таблицу

FETCH NEXT FROM line_cursor INTO @line;

END

CLOSE line_cursor;

DEALLOCATE line_cursor;

После обработки удалите временную таблицу:

DROP TABLE #TempImport;

Избегайте чтения больших файлов целиком – это приведёт к нагрузке на память. При необходимости реализуйте пакетную загрузку с отслеживанием позиции в файле. Учитывайте кодировку и корректный формат окончания строк.

Работа с разделителями и кодировкой в текстовом файле

При переносе данных из текстового файла в базу данных SQL ключевую роль играют правильный выбор разделителей и кодировки. Ошибки на этом этапе могут привести к некорректному импорту данных и потере информации.

Разделители в текстовом файле определяют, как данные разделяются на отдельные элементы. Наиболее распространены два типа: запятая (CSV) и табуляция (TSV). Важно понимать, что выбор разделителя зависит от содержания данных. Например, если в полях текста встречаются запятые, использование запятой как разделителя приведет к неправильной интерпретации данных. В таком случае лучше использовать табуляцию или другой уникальный символ.

Если вы работаете с CSV-файлом, убедитесь, что текстовые поля, содержащие разделители, заключены в кавычки. Это предотвратит ошибочную интерпретацию данных. Например, строка «Иванов, Иван» будет корректно интерпретирована как одно поле, если находится в кавычках: «Иванов, Иван».

Что касается кодировки, важно выбирать ту, которая соответствует требованиям как исходного файла, так и системы, в которую происходит импорт данных. Наиболее часто используются кодировки UTF-8 и Windows-1251. UTF-8 подходит для большинства современных систем и поддерживает все символы. Однако, если файл изначально был сохранен в Windows-1251, и вы не укажете эту кодировку при импорте, символы могут отображаться некорректно.

Перед импортом данных в SQL следует убедиться, что выбранная кодировка правильно распознается в источнике. Например, при использовании Python для чтения файла с текстом важно указать правильную кодировку в функции open(), чтобы избежать проблем с чтением нестандартных символов.

Рекомендуется заранее проверять файл на наличие нестандартных символов и, если необходимо, очистить его от них. Некоторые редакторы, такие как Notepad++ или Sublime Text, позволяют конвертировать кодировку файла, что также может быть полезно для предотвращения ошибок при импорте данных в базу данных.

Импорт данных с использованием утилиты bcp

Утилита bcp (Bulk Copy Program) предназначена для быстрого и эффективного импорта и экспорта данных между файлами и базой данных SQL Server. Этот инструмент полезен, когда необходимо обработать большие объемы данных и минимизировать время на перенос информации.

Процесс импорта данных в SQL Server с использованием bcp включает несколько ключевых этапов:

- Подготовка исходного файла. Это должен быть текстовый файл, содержащий данные, разделенные определенным символом (например, запятой или табуляцией). Для каждого столбца должен быть задан соответствующий формат.

- Создание таблицы в базе данных, если она еще не существует. Структура таблицы должна совпадать с форматом данных в файле.

- Запуск команды

bcpдля импорта данных в таблицу SQL Server.

Основной командой для импорта данных является:

bcp <имя_таблицы> in <путь_к_файлу> -S <сервер> -U <пользователь> -P <пароль> -c -t <разделитель>Где:

имя_таблицы– название таблицы в базе данных SQL Server.путь_к_файлу– полный путь к текстовому файлу, содержащему данные.-S– имя или IP-адрес сервера SQL.-Uи-P– учетные данные для подключения к базе данных (пользователь и пароль).-c– флаг, указывающий на использование символов в качестве формата данных (например, текст).-t– разделитель, используемый в файле (по умолчанию – табуляция, но можно указать другие символы).

Пример команды для импорта данных:

bcp mydatabase.dbo.mytable in "C:\data\file.txt" -S localhost -U sa -P password -c -t ,При необходимости можно указать дополнительные параметры для точной настройки процесса импорта. Например, использование флага -r позволяет задать символ, который будет использоваться для разделения строк в файле.

Перед импортом данных важно проверить соответствие типов данных в файле и таблице. Если в исходном файле есть несоответствия, команда bcp может завершиться с ошибками. Рекомендуется заранее подготовить и протестировать файлы данных, чтобы исключить возможные проблемы при импорте.

Утилита bcp также предоставляет возможность использования форматов, что позволяет импортировать данные с учетом специфики структуры таблиц, например, при работе с датами или числовыми значениями.

После завершения операции импорта можно выполнить проверку данных с помощью стандартных запросов в SQL Server, чтобы убедиться, что все данные корректно перенесены в целевую таблицу.

Отладка ошибок импорта и проверка результата загрузки

При импорте данных из файла TXT в SQL-базу данных ошибки могут возникать на различных этапах. Чтобы эффективно устранить проблемы, важно заранее настроить логирование и внимательно проверять все шаги процесса.

Первое, на что стоит обратить внимание – это корректность данных в исходном файле. Проверьте, нет ли пустых строк, неправильных символов или несоответствий формата. Например, если ожидаются числовые значения, а в файле встречаются текстовые символы, это приведет к ошибкам во время загрузки. Использование функций в SQL для предварительной проверки данных, например, проверка на NULL или на определенные диапазоны значений, поможет избежать подобных проблем.

Второе – это логирование процесса импорта. Включите подробное логирование ошибок, чтобы получать информацию о каждой проблемной строке или записи. Большинство инструментов импорта (например, SQL Server Integration Services) позволяют настроить журнал ошибок, который будет содержать информацию о неудачных попытках вставки. Это позволит быстро идентифицировать источник проблемы, будь то нарушение формата данных, ограничения целостности или нарушения уникальности.

Третье – проверка индексов и ограничений целостности базы данных. Если данные не проходят импорт из-за нарушения уникальности или внешних ключей, важно сначала проанализировать структуру базы данных. Убедитесь, что в процессе импорта не нарушаются условия уникальности, а также проверьте зависимости между таблицами. Иногда помогает временное отключение индексов и ограничений, чтобы выявить, на каком именно этапе происходит сбой.

После завершения импорта необходимо провести проверку результатов. Это можно сделать с помощью запросов на выборку данных, чтобы удостовериться в корректности загруженной информации. Важно сравнить количество строк в исходном файле и в целевой таблице. Также полезно использовать агрегатные функции для проверки целостности данных, например, суммирование значений или подсчет записей по группам. Это поможет выявить пропущенные или неправильно обработанные данные.

Не забывайте про тестирование на малых данных. Перед запуском импорта больших объемов данных проведите пробный импорт небольшой выборки, чтобы заранее выявить потенциальные ошибки и протестировать механизм обработки данных. Это позволяет существенно сократить время на устранение ошибок в более поздних этапах процесса.

Вопрос-ответ:

Как перенести данные из TXT файла в SQL базу данных?

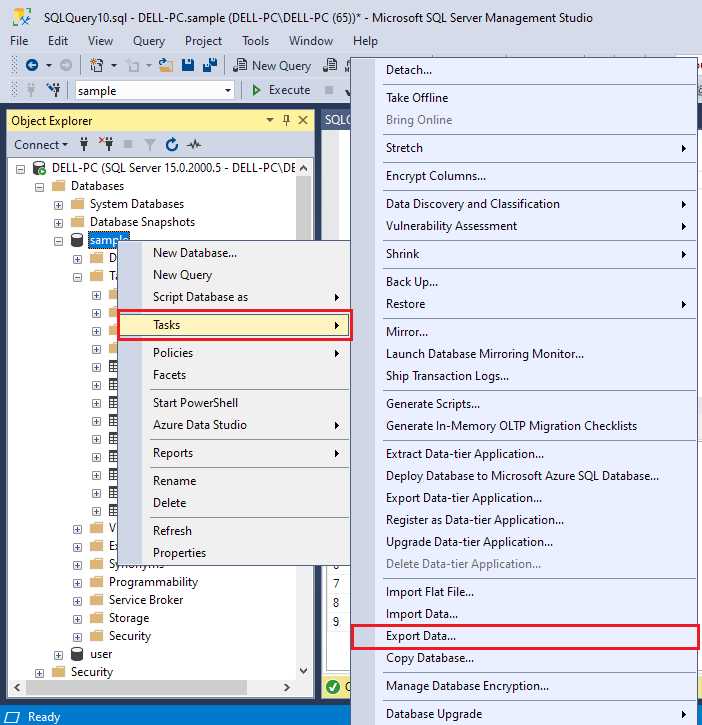

Для переноса данных из текстового файла в SQL базу данных можно использовать несколько методов. Один из самых простых – это использовать команду BULK INSERT или форматирование данных с помощью SQL Server Management Studio. При этом файл TXT должен быть структурирован (например, с разделителями для столбцов) и соответствовать формату, который ожидает база данных. Сначала нужно создать таблицу в SQL Server, затем настроить BULK INSERT для загрузки данных. Также можно использовать инструменты ETL, такие как SQL Server Integration Services (SSIS), для более сложных преобразований.

Какие ошибки могут возникнуть при переносе данных из TXT файла в SQL?

Основные ошибки при переносе данных из TXT файла в базу данных SQL могут быть связаны с несовпадением форматов данных. Например, если в текстовом файле есть строки с неправильным числовым форматом или дату представлено в неверном виде, SQL Server может не принять такие значения. Также возможны проблемы с разделителями (например, если текстовый файл использует другой символ-разделитель, а не запятую или табуляцию). Для корректного переноса важно предварительно проверить и очистить данные в файле, чтобы они соответствовали структуре таблицы.

Какие способы существуют для массового переноса данных из TXT файла в SQL?

Для массового переноса данных из TXT файла в SQL можно использовать несколько подходов. Один из них — это BULK INSERT, который позволяет быстро загружать большие объемы данных. Для этого достаточно указать путь к файлу и настроить параметры (например, разделители). Второй способ — использование SQL Server Integration Services (SSIS), который предоставляет более гибкие инструменты для обработки данных, включая очистку и преобразование. Также можно использовать команду BCP (Bulk Copy Program) для массовой загрузки данных через командную строку. Эти методы подходят для обработки больших объемов данных, что особенно важно при работе с текстовыми файлами, содержащими тысячи записей.

Как избежать ошибок при импорте данных из TXT в SQL, если файл содержит пропущенные значения?

Для предотвращения ошибок при импорте данных из TXT файла в SQL, если файл содержит пропущенные значения, можно использовать несколько подходов. Один из них — это настройка предустановленных значений для пустых полей в SQL Server. Например, можно указать NULL или значение по умолчанию для колонок, где данные могут быть отсутствуют. Также рекомендуется проверять формат данных в файле перед загрузкой, чтобы убедиться, что пропущенные значения корректно обрабатываются. Важно учитывать, что пропуски данных могут возникать как в отдельных строках, так и в целых колонках, поэтому нужно тщательно анализировать структуру исходного файла.