Парсинг поисковых запросов Яндекса позволяет извлечь информацию о популярных и актуальных темах для различных областей. Это необходимо для более точного таргетинга контента, анализа конкурентов и улучшения SEO-стратегии. Использование правильных инструментов и подходов значительно повышает эффективность анализа.

Для парсинга запросов Яндекса можно использовать API Яндекс.Вебмастера, а также сторонние сервисы и библиотеки, такие как BeautifulSoup или Scrapy, которые позволяют собирать и обрабатывать данные с помощью Python. Также важно учитывать ограничения Яндекса на частоту запросов, чтобы избежать блокировок или других санкций.

Кроме того, необходимо учитывать важность корректной фильтрации результатов. Например, чтобы исключить нерелевантные запросы, можно использовать фильтры по географическому положению или по времени. Для этого потребуется настроить дополнительные параметры в запросах API Яндекс.Вебмастера или вручную обрабатывать полученные данные.

Систематический подход к парсингу запросов позволяет выявить тренды, использовать данные для улучшения контента и стратегий продвижения. Важно помнить, что не все запросы одинаково полезны, поэтому важно проводить регулярные обновления данных и отслеживать изменения в алгоритмах Яндекса.

Настройка API Яндекса для получения данных

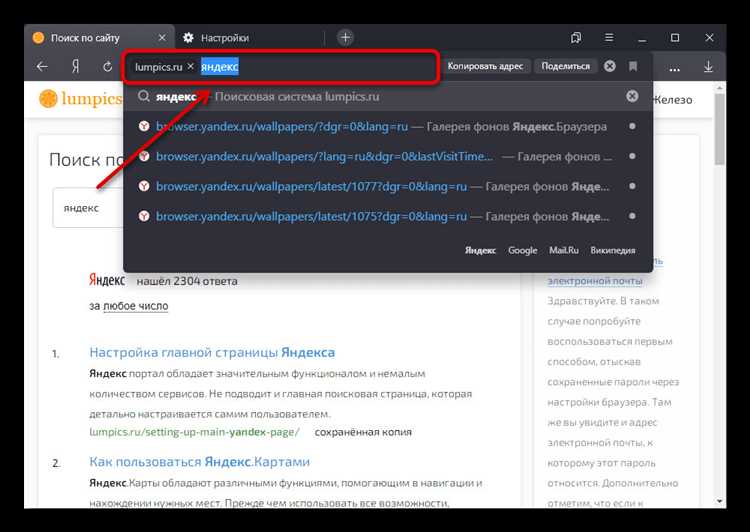

Для работы с API Яндекса необходимо создать и настроить проект в Яндекс.Облаке или через Яндекс.Директ API, в зависимости от типа данных, которые вы хотите получать.

Первым шагом является регистрация в Яндекс.Облаке и создание проекта. Перейдите в раздел «API и сервисы», выберите необходимый сервис и создайте ключ доступа. В случае с Яндекс.Директ API для работы с поисковыми запросами и рекламными кампаниями понадобится ключ, который можно получить в разделе «Мои API».

После регистрации и создания ключа получите OAuth токен для аутентификации. Он необходим для отправки запросов и получения данных от Яндекса. Для этого используйте сервис OAuth Яндекса. Токен можно получить через стандартный процесс аутентификации, используя ваши данные для входа в Яндекс.

Когда ключ и токен настроены, можно использовать Яндекс API для отправки запросов и получения данных. Пример запроса для получения данных о поисковых запросах через Яндекс.Метрика или Яндекс.Директ API включает в себя указание параметров, таких как фильтры по регионам, типам устройств, языкам, временным периодам и другим меткам.

Для реализации запросов можно использовать стандартные библиотеки для работы с API (например, requests в Python) или готовые SDK от Яндекса. Это упростит процесс подключения и обработки полученных данных.

Для проверки правильности работы API и получения корректных данных, важно соблюдать лимиты запросов и использовать обработку ошибок, предусмотренную документацией. Это поможет избежать блокировки и неправильной работы с сервисом.

Выбор инструментов для парсинга запросов

При выборе инструмента для парсинга запросов в Яндексе важно учитывать несколько ключевых факторов: точность, скорость работы и простота настройки. На рынке существует несколько решений, каждое из которых подходит для различных целей.

1. Яндекс.Вордстат – базовый инструмент для анализа поисковых запросов, который доступен через официальный API. Он позволяет получать статистику по запросам, а также использовать фильтры для более точных данных. Главный минус – ограничения на количество запросов и отсутствие полной гибкости в обработке данных.

2. Scrapy – популярный фреймворк для веб-скрейпинга. Подходит для опытных разработчиков, позволяя создавать кастомизированные парсеры с высокой производительностью. Scrapy поддерживает многозадачность и может работать с большими объемами данных. Его недостаток – необходимость наличия знаний Python для настройки и оптимизации процессов.

3. Octoparse – визуальный парсер, ориентированный на пользователей без технического опыта. Он предлагает удобный интерфейс для создания парсеров, который подходит для простых задач, таких как сбор запросов по ключевым словам. Однако Octoparse не всегда справляется с сложными структурами сайтов и может ограничивать пользователей в плане гибкости.

4. SerpApi – сервис, предоставляющий API для получения результатов поисковой выдачи из Яндекса и других поисковиков. Он поддерживает различные фильтры и параметры, что позволяет детально настраивать парсинг. Однако, стоимость API может быть высокой при частом использовании.

5. ParseHub – еще один визуальный парсер с мощными возможностями для сбора данных с сайтов. Подходит для более сложных случаев, поддерживает различные типы запросов и может работать с динамическими страницами. Однако, для использования всех функций потребуется платная подписка.

Выбор инструмента зависит от объема задач и технической подготовки. Для небольших проектов подойдет Яндекс.Вордстат или Octoparse, для более сложных сценариев стоит рассмотреть Scrapy или SerpApi. Важно помнить, что эффективность работы с каждым инструментом напрямую зависит от правильной настройки и понимания особенностей работы с данными Яндекса.

Как собирать данные по частотности запросов

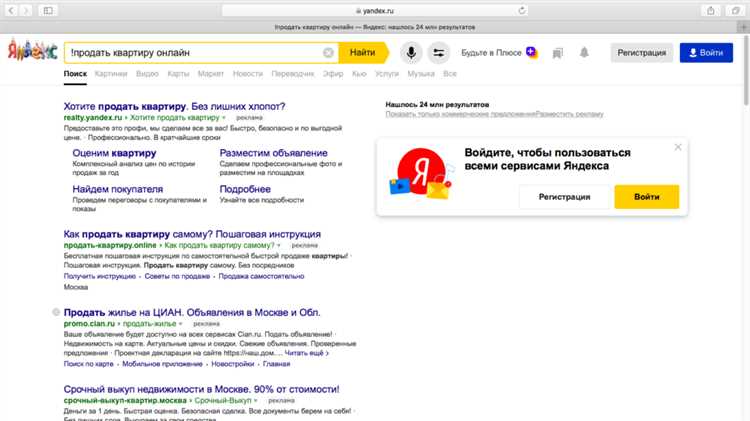

Для сбора данных по частотности запросов в Яндексе необходимо использовать Яндекс.Вордстат или сторонние инструменты. Яндекс.Вордстат предоставляет точную информацию о частоте запросов в поисковой системе. Чтобы начать собирать данные, нужно зайти в сервис и ввести интересующие запросы. Он покажет статистику по регионам и динамике запросов.

Для более глубокого анализа можно использовать API Яндекс.Вордстат. Для этого потребуется зарегистрировать приложение на Яндекс.Облаке и получить ключ для доступа. В API доступна информация о частотности, конкуренции и связанных запросах, что помогает выстраивать точную стратегию контента и SEO.

Еще один способ – использование специализированных сервисов, таких как KeyCollector или Serpstat. Эти инструменты позволяют не только собирать частотность запросов, но и анализировать данные по ключевым словам на основе нескольких источников. Они обеспечивают фильтрацию по регионам, уточнение по времени и конкурентности запросов.

Собранные данные можно экспортировать в форматах CSV или Excel для дальнейшей обработки и анализа. Эти форматы позволяют использовать фильтрацию, сортировку и графическое представление для выявления ключевых тенденций и оптимизации контента.

Обработка и фильтрация полученных данных

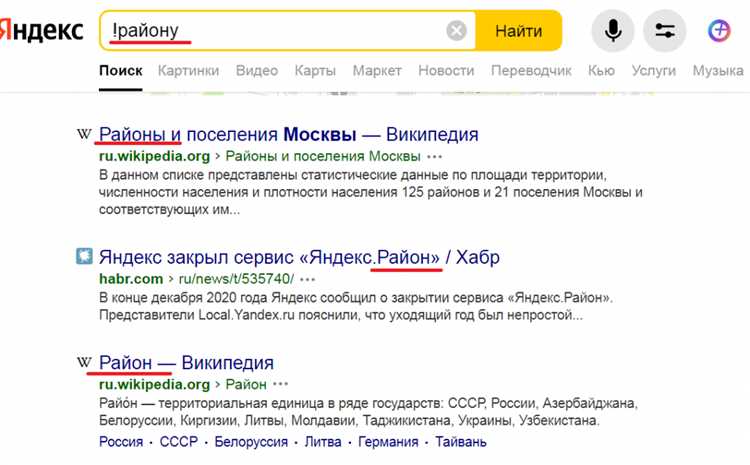

Первым шагом является удаление стоп-слов. Стоп-слова – это слова, которые не несут смысловой нагрузки для анализа запросов. Например, слова «как», «где», «что», «когда», «и» и прочие часто встречаются в поисковых запросах, но не дают ценную информацию о намерениях пользователя. Для этого можно использовать готовые списки стоп-слов или создать собственный, учитывая специфику тематики.

Далее следует фильтрация по частоте. Запросы, которые появляются слишком часто (например, те, которые включают названия популярных брендов или общие фразы), могут искажать анализ. Чтобы исключить такие запросы, можно задать минимальную и максимальную частоту их появления в выборке. Например, запросы, которые встречаются меньше 5 раз или более 1000 раз, можно исключить из анализа.

После этого необходимо нормализовать запросы. Это включает в себя приведение слов к начальной форме (лемматизация) и удаление избыточных символов (например, лишних пробелов или знаков препинания). Также полезно объединить схожие запросы. Например, запросы «купить ноутбук» и «ноутбук купить» можно считать одинаковыми.

Фильтрация по длине запроса – еще один важный этап. Длинные или очень короткие запросы часто оказываются нерелевантными для большинства видов анализа. Короткие запросы могут быть слишком общими, а длинные – слишком специфичными. Оптимальная длина запроса зависит от задачи, но обычно запросы длиной от 3 до 5 слов дают наилучший результат.

В конце важно удалить дубликаты запросов. Это можно сделать с помощью простых алгоритмов поиска и удаления повторяющихся элементов в списке запросов. Часто дубли возникают из-за случайных ошибок при сборе данных, поэтому этот шаг помогает повысить точность анализа.

Анализ конкуренции по ключевым фразам

Анализ конкуренции по ключевым фразам помогает определить, насколько сложно будет продвигать сайт по конкретному запросу в Яндексе. Для этого нужно учитывать несколько ключевых факторов, таких как количество конкурентов, качество контента и их авторитетность.

Для начала проведите анализ ТОП-10 по нужному запросу. Оцените, какие сайты занимают высокие позиции, и как они оптимизируют страницы:

- Посмотрите на плотность ключевых слов на страницах.

- Оцените качество текстового контента и его релевантность запросу.

- Изучите использование мультимедийных элементов (картинки, видео, графика).

- Проверьте возраст и авторитетность сайтов с помощью инструментов для анализа ссылок (например, Ahrefs или SimilarWeb).

Важно обращать внимание на следующие метрики:

- Ссылки на страницы: чем больше ссылок на сайт, тем выше конкуренция. Ищите возможность получить качественные обратные ссылки.

- Частота обновления контента: свежий контент помогает сайтам оставаться актуальными.

- Мобильная адаптация: сайты, которые хорошо оптимизированы для мобильных устройств, имеют преимущества в мобильном поиске.

Также важно учитывать поведение пользователей: время на сайте, количество отказов, глубина просмотра страниц. Эти параметры влияют на рейтинг в поисковой системе.

Для более точного анализа конкуренции используйте специальные инструменты, такие как Яндекс.Вебмастер и сервисы для анализа поисковых запросов. Они помогут выявить, какие ключевые слова приносят больше трафика и какие конкуренты имеют схожие стратегии.

Анализ конкуренции – это не просто изучение первых позиций в поисковой выдаче. Важно также выявлять возможности для улучшения своей страницы по каждому запросу. Системный подход и использование данных для создания уникального контента и ссылочной массы позволят повысить шансы на успех.

Сохранение и визуализация результатов анализа

Сохранение данных должно быть организовано с учетом структуры и объема собранной информации. Лучший способ – использование форматов CSV или JSON. Эти форматы позволяют легко обрабатывать и интегрировать данные в другие системы, например, для дальнейшего анализа с помощью Python или других инструментов обработки данных.

Важным моментом является выбор подходящего метода хранения. Если анализ выполняется регулярно, можно использовать базы данных, такие как MySQL или PostgreSQL, что обеспечит удобство и масштабируемость при работе с большими объемами информации. Для временных данных подойдут файловые системы или облачные сервисы (например, Google Drive, Dropbox).

Визуализация результатов помогает выделить ключевые тренды и паттерны, которые могут быть упущены при анализе только числовых данных. Один из популярных инструментов для визуализации – Matplotlib в Python. С его помощью можно строить графики, которые показывают динамику изменений, распределение запросов по регионам или частоте использования.

Для простоты восприятия визуализации можно использовать облачные сервисы, такие как Google Data Studio или Tableau. Эти инструменты позволяют строить дашборды, которые легко адаптируются под изменяющиеся данные и могут быть использованы для отслеживания результатов в реальном времени.

Также полезным является использование тепловых карт для визуализации частотности запросов по регионам, что поможет выявить географические паттерны. Для этого можно использовать Heatmaps в Python или интегрировать данные с картами Google.

Чтобы визуализация была максимально информативной, стоит учесть правильный выбор типов графиков. Например, для анализа сезонных колебаний запросов лучше использовать линейные графики, а для сравнения частоты различных запросов – столбчатые диаграммы.

Правильное сохранение и эффективная визуализация позволяют не только глубже понять данные, но и оперативно реагировать на изменения в поисковой активности пользователей.

Вопрос-ответ:

Как правильно парсить поисковые запросы в Яндексе для анализа?

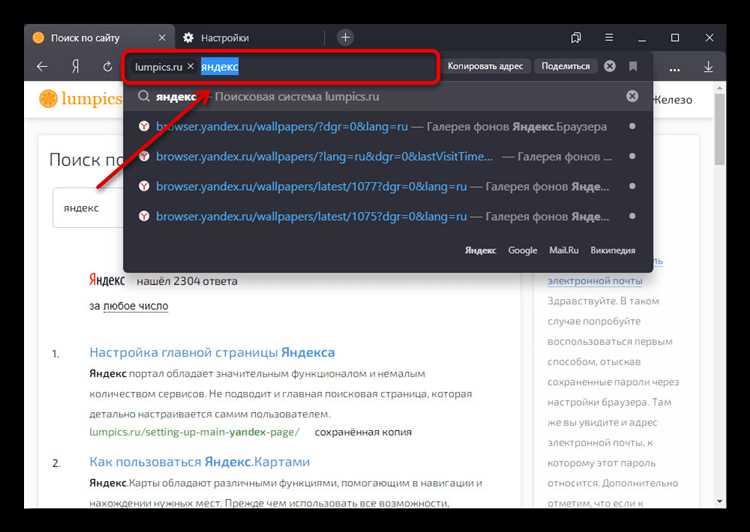

Для парсинга поисковых запросов в Яндексе необходимо использовать специальные инструменты, такие как API Яндекса или парсеры. Важно настраивать запросы с учетом нужд анализа, чтобы получать релевантные данные о частоте запросов, трендах и популярных фразах. Для этого можно использовать программы, которые позволяют автоматизировать процесс сбора данных с поисковых систем, или же анализировать открытые источники с результатами поиска.

Какие инструменты лучше всего подходят для парсинга запросов в Яндексе?

Для парсинга запросов в Яндексе используются различные инструменты, такие как Serpstat, SEMrush, а также специализированные парсеры, например, «Яндекс. Вебмастер» и «Rank Math». Эти инструменты позволяют собирать информацию о частоте запросов, фразах, которые приводят к переходам на сайты, и даже об актуальных трендах. Некоторые из них также предоставляют доступ к данным по ключевым словам, что помогает в SEO-оптимизации.

Что такое частота запросов и как её правильно использовать при анализе?

Частота запросов — это показатель того, как часто конкретное слово или фраза используется пользователями в поисковой системе. Этот параметр полезен для понимания популярности темы. При анализе частоты запросов важно учитывать сезонность, изменения в трендах и поведение аудитории. Часто низкочастотные запросы могут давать более точные данные для узкой аудитории, в то время как высокочастотные запросы лучше подходят для массовых проектов.

Какие данные можно получить при парсинге запросов в Яндексе?

При парсинге поисковых запросов можно получить различные данные, включая частотность запросов, конкуренцию по ключевым словам, а также информацию о том, как часто пользователи ищут определённые фразы. Также можно анализировать результаты поисковой выдачи, например, какие сайты чаще всего появляются по запросам, что поможет выявить наиболее конкурентные области. Это позволяет строить эффективные стратегии контент-маркетинга и SEO-оптимизации.

Как избежать ошибок при парсинге запросов и анализе данных?

Чтобы избежать ошибок при парсинге запросов, важно тщательно настраивать параметры поиска, следить за качеством собранных данных и корректно интерпретировать результаты. Например, следует учитывать возможные ошибки в запросах, использование синонимов или опечаток. Также важно периодически обновлять парсер и его настройки, чтобы он учитывал актуальные изменения в поисковой выдаче и алгоритмах Яндекса.