CSV (Comma-Separated Values) – это один из самых популярных форматов для обмена данными, благодаря своей простоте и совместимости с различными системами. Однако для полноценного анализа или работы с данными часто требуется загрузить их в реляционную базу данных, такую как SQL. Этот процесс не всегда очевиден, особенно если база данных имеет специфические требования к структуре данных. Важно понимать, как правильно открыть и импортировать CSV файл, чтобы избежать ошибок и не потерять информацию.

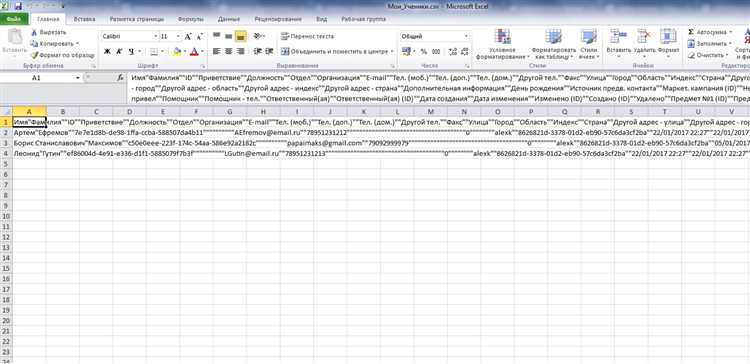

Основной задачей при импорте CSV в SQL является правильная обработка данных. CSV файлы могут содержать лишние пробелы, неправильные символы разделителей или неструктурированные значения, которые могут привести к сбоям в процессе загрузки. При этом важно убедиться, что типы данных в CSV файле соответствуют типам в базе данных. Например, строки, представляющие даты или числа, должны быть корректно интерпретированы и преобразованы в соответствующие типы данных в SQL.

Примерный процесс импорта включает несколько ключевых этапов. Сначала нужно выбрать подходящий метод загрузки данных. В зависимости от СУБД это может быть команда LOAD DATA INFILE для MySQL или BULK INSERT для SQL Server. На этом этапе также важно настроить правильный разделитель и кодировку, чтобы данные были корректно интерпретированы.

После импорта данных важно провести их проверку. Необходимо убедиться, что все записи были загружены без потерь и ошибок. Один из распространенных методов проверки – это создание контрольных запросов для подсчета строк в таблице и сравнение их с количеством строк в исходном CSV файле. В случае несоответствий, следует провести диагностику на уровне структуры данных или исследовать возможные проблемы с кодировкой файла.

Как импортировать CSV файл в базу данных SQL с помощью командной строки

Импорт CSV файла в базу данных SQL можно осуществить с помощью различных утилит, доступных в командной строке. Этот процесс может значительно ускорить загрузку данных в таблицы базы данных. Рассмотрим два наиболее популярных способа импорта для MySQL и PostgreSQL.

1. MySQL

Для импорта CSV файла в MySQL можно использовать команду LOAD DATA INFILE. Важно, чтобы файл находился на сервере или был доступен для чтения через путь, который указывается в команде. Структура команды следующая:

LOAD DATA INFILE '/путь/к/файлу.csv'

INTO TABLE имя_таблицы

FIELDS TERMINATED BY ','

ENCLOSED BY '"'

LINES TERMINATED BY '\n'

IGNORE 1 LINES;Здесь:

/путь/к/файлу.csv– путь к файлу на сервере;имя_таблицы– имя таблицы, в которую будут загружены данные;FIELDS TERMINATED BY ','– указывает разделитель между полями (в CSV это запятая);ENCLOSED BY '"'– указывает, что значения могут быть заключены в кавычки;LINES TERMINATED BY '\n'– указывает, что строки данных разделяются символом новой строки;IGNORE 1 LINES– пропускает первую строку, если она содержит заголовки.

Если файл находится на локальной машине и MySQL сервер настроен для работы с внешними файлами, можно использовать опцию LOCAL, которая указывает на файл, доступный с клиента:

LOAD DATA LOCAL INFILE '/путь/к/файлу.csv'

INTO TABLE имя_таблицы

FIELDS TERMINATED BY ','

ENCLOSED BY '"'

LINES TERMINATED BY '\n'

IGNORE 1 LINES;Для корректной работы этой команды требуется, чтобы в MySQL был разрешен доступ к локальным файлам через параметр local_infile.

2. PostgreSQL

В PostgreSQL используется команда COPY для импорта CSV файлов. Пример команды:

COPY имя_таблицы FROM '/путь/к/файлу.csv' DELIMITER ',' CSV HEADER;Параметры:

имя_таблицы– название таблицы для импорта;/путь/к/файлу.csv– путь к CSV файлу;DELIMITER ','– разделитель полей;CSV– указывает формат файла как CSV;HEADER– пропускает первую строку с заголовками.

Если CSV файл имеет нестандартный разделитель или обрамляющие символы, их можно настроить с помощью дополнительных параметров, например QUOTE для определения символа, который заключает значения.

3. Общие рекомендации

При импорте CSV файла важно учитывать следующие моменты:

- Убедитесь, что структура таблицы в базе данных соответствует данным в CSV файле (тип данных и количество столбцов).

- Если в CSV файле есть символы, не являющиеся стандартными для SQL (например, специальные символы или пробелы), их необходимо корректно экранировать или удалить до импорта.

- Используйте параметр

IGNOREили аналогичные, чтобы избежать ошибок при загрузке данных с лишними строками заголовков или пустыми строками. - При необходимости оптимизируйте процесс импорта, отключив индексы и триггеры, а затем восстанавливая их после завершения операции.

Использование SQL-запросов для загрузки данных из CSV в таблицу

Для загрузки данных из CSV файла в таблицу SQL базы данных можно использовать несколько подходов, каждый из которых зависит от используемой СУБД и доступных инструментов. Ниже рассмотрены основные методы, которые могут быть полезны при интеграции CSV данных в SQL таблицы.

Перед началом загрузки данных из CSV важно учесть форматирование файла. CSV должен быть структурирован так, чтобы соответствовать столбцам в целевой таблице базы данных. Каждый столбец в CSV должен соответствовать типу данных в таблице SQL, а разделители (обычно запятая или точка с запятой) должны быть правильно указаны.

Примеры SQL-запросов для различных СУБД:

- PostgreSQL: В PostgreSQL для загрузки данных используется команда

COPY, которая позволяет эффективно загружать большие объемы данных.

COPY имя_таблицы(столбец1, столбец2, столбец3)

FROM '/путь/к/файлу.csv'

DELIMITER ','

CSV HEADER;Здесь:

имя_таблицы– имя таблицы, в которую загружаются данные;столбец1, столбец2, столбец3– список столбцов в таблице, куда будут загружены данные;DELIMITER– разделитель, который используется в CSV (запятая, точка с запятой и т.д.);CSV HEADER– указывает на то, что первый ряд в CSV файле является заголовком.

- MySQL: В MySQL для загрузки данных используется команда

LOAD DATA INFILE.

LOAD DATA INFILE '/путь/к/файлу.csv'

INTO TABLE имя_таблицы

FIELDS TERMINATED BY ','

ENCLOSED BY '"'

LINES TERMINATED BY '\n'

IGNORE 1 ROWS;Параметры запроса:

FIELDS TERMINATED BY– разделитель полей;ENCLOSED BY– символ, который обрамляет данные в CSV (например, кавычки);LINES TERMINATED BY– разделитель строк;IGNORE 1 ROWS– пропуск первой строки с заголовками.

- SQL Server: В SQL Server для импорта данных из CSV файла можно использовать команду

BULK INSERT.

BULK INSERT имя_таблицы

FROM 'C:\путь\к\файлу.csv'

WITH (

FIELDTERMINATOR = ',',

ROWTERMINATOR = '\n',

FIRSTROW = 2

);Здесь:

FIELDTERMINATOR– указывает разделитель полей;ROWTERMINATOR– указывает разделитель строк;FIRSTROW = 2– пропуск первой строки с заголовками.

Для более точной настройки загрузки данных могут использоваться дополнительные параметры, такие как обработка ошибок, проверки типов данных и соответствие форматов даты и времени.

Для упрощения процесса загрузки данных рекомендуется:

- Проверить и стандартизировать формат CSV файла перед загрузкой;

- Провести предварительную проверку данных в файле для предотвращения ошибок при загрузке;

- Использовать транзакции для гарантии целостности данных, особенно при загрузке больших объемов;

- Регулярно очищать таблицы перед загрузкой новых данных, если это необходимо, чтобы избежать дублирования.

Обработка различных форматов CSV при импорте в SQL

CSV файлы могут иметь разные структуры, что влияет на их обработку при импорте в базу данных SQL. Правильное понимание этих форматов помогает избежать ошибок и ускоряет процесс загрузки данных.

Основные особенности CSV файлов, на которые стоит обратить внимание:

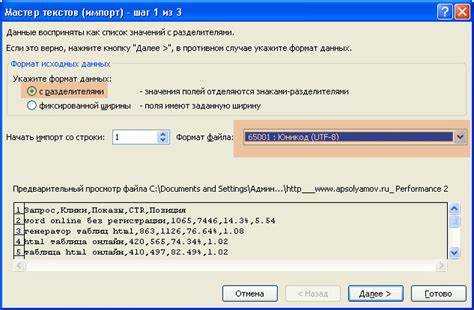

- Разделители: Вместо стандартной запятой (,) могут использоваться другие символы, такие как точка с запятой (;), табуляция или пробел. При настройке импорта важно указать правильный разделитель, чтобы SQL правильно интерпретировал данные.

- Кавычки для значений: Некоторые CSV файлы используют кавычки («) для обозначения значений, содержащих запятые или специальные символы. Если кавычки не будут учтены, SQL может некорректно интерпретировать данные.

- Заголовки столбцов: В некоторых случаях строки с заголовками столбцов могут быть включены в CSV файл. При импорте в SQL такие строки нужно исключить или корректно обработать, чтобы они не стали частью данных.

- Пробелы и пустые значения: Пустые ячейки в CSV могут быть интерпретированы по-разному: как NULL или как пустая строка. Важно заранее настроить SQL на правильную обработку таких значений.

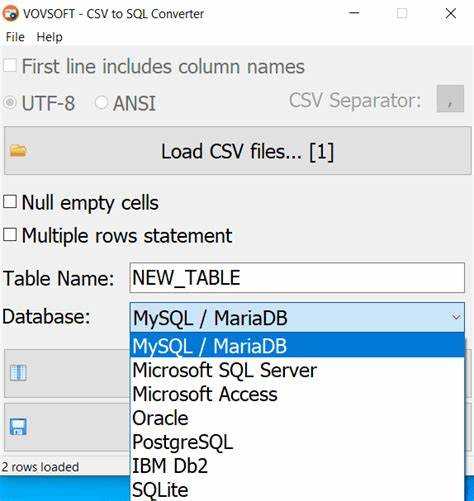

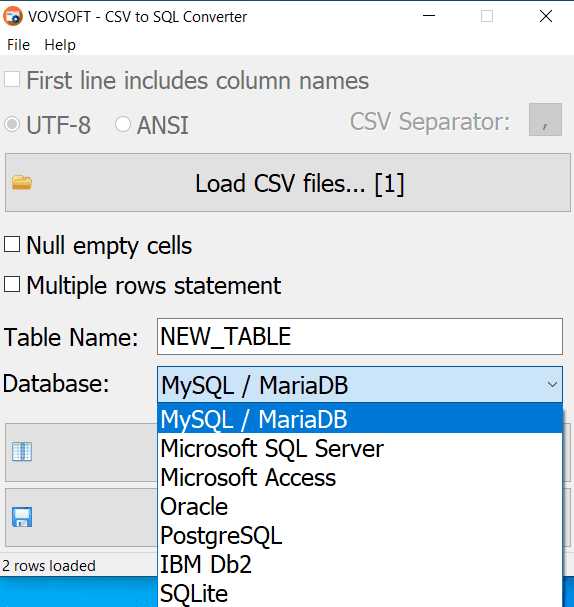

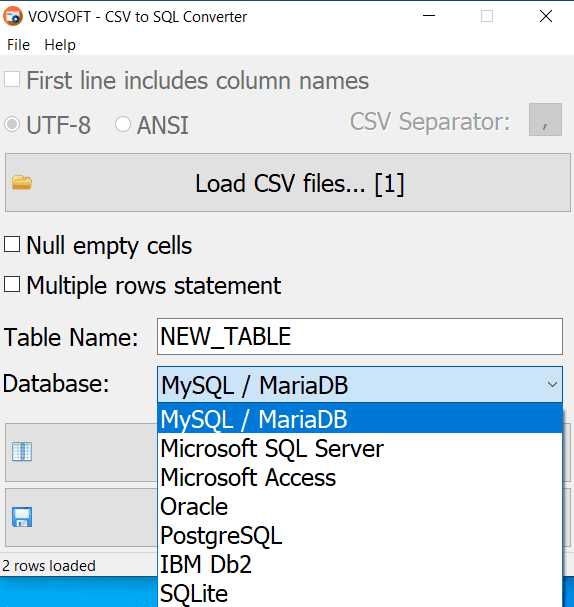

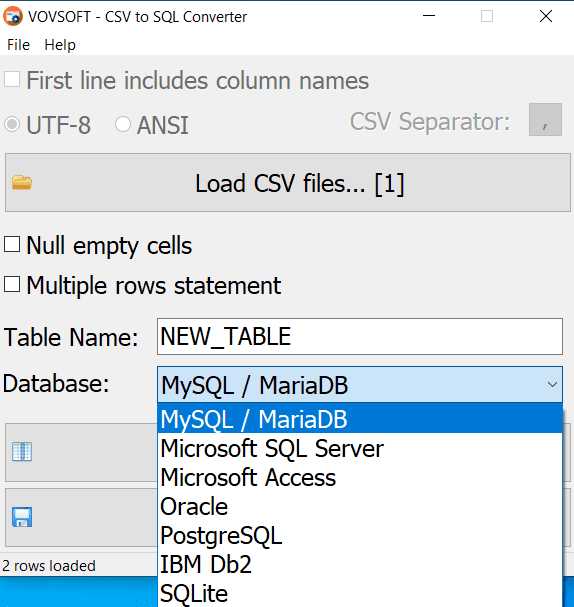

- Кодировка: CSV файлы могут использовать различные кодировки, например, UTF-8 или Windows-1251. Ошибки в кодировке могут привести к неправильному отображению символов и нарушению структуры данных.

Процесс импорта данных зависит от этих факторов и может потребовать дополнительных настроек в SQL. Например, в MySQL для указания разделителя используется параметр FIELDS TERMINATED BY, а для обработки кавычек – ENCLOSED BY.

Некоторые рекомендации для успешной обработки:

- Проверьте разделитель перед загрузкой данных. При необходимости откорректируйте его в настройках импорта.

- Используйте опцию игнорирования первой строки с заголовками, если она присутствует в файле.

- Убедитесь, что данные с пробелами или специальными символами заключены в кавычки, чтобы избежать ошибок импорта.

- Убедитесь, что кодировка CSV файла соответствует ожиданиям SQL базы данных, чтобы избежать проблем с отображением символов.

Каждый из этих факторов имеет прямое влияние на корректность данных, поэтому важно заранее проанализировать CSV файл и подготовить SQL сервер для работы с ним.

Настройка разделителей и кавычек для правильного чтения CSV файлов

Для успешного импорта CSV-файлов в базу данных SQL важно правильно настроить параметры разделителей и кавычек. Это позволяет избежать ошибок при чтении данных и обеспечивает корректную обработку строк с текстовыми значениями, содержащими запятые или другие специальные символы.

Часто в качестве разделителей используется запятая (`,`), но для файлов с данными, содержащими запятые в полях, в качестве разделителя может быть выбран символ точки с запятой (`;`) или табуляция (`\t`). Чтобы указать правильный разделитель, нужно точно знать, какой символ используется в файле. Если файл использует нестандартный разделитель, например, табуляцию, при импорте необходимо явно указать это в настройках загрузки данных.

Кроме того, при обработке CSV-файлов важно учитывать символы кавычек. Обычно используется двойная кавычка (`»`) для обрамления строковых значений, чтобы избежать конфликтов с разделителями внутри поля. Это особенно актуально для значений, которые содержат запятые или символы новой строки. Важно правильно настроить параметры импорта, чтобы кавычки не интерпретировались как часть данных. Если в файле используются одинарные кавычки, или они отсутствуют, настройку следует адаптировать под это.

Если в CSV-файле присутствуют кавычки внутри строк, необходимо настроить параметр экранирования. Например, двойные кавычки внутри строки часто экранируются с помощью пары двойных кавычек (`»»`). Важно обеспечить, чтобы процесс импорта корректно обрабатывал такие случаи и не приводил к повреждению данных.

При настройке импорта также стоит обратить внимание на параметры кодировки. В случае, если файл содержит текст на разных языках, предпочтительнее использовать кодировку UTF-8, чтобы избежать проблем с интерпретацией символов.

Некоторые СУБД и инструменты импорта предлагают дополнительные параметры, такие как пропуск пустых строк, обработка ошибок при встрече некорректных значений и фильтрация данных перед загрузкой в таблицы. Важно не упустить эти настройки, чтобы избежать ошибок и повысить эффективность процесса загрузки данных.

Как избежать ошибок при импорте данных из CSV в SQL таблицы

Проверьте разделители. В большинстве случаев в CSV используется запятая или точка с запятой в качестве разделителя. Убедитесь, что выбранный разделитель в CSV совпадает с настройками импорта в вашей СУБД. Например, для PostgreSQL и MySQL разделитель может быть указан явно через параметр, и если это не будет сделано, вы получите некорректно интерпретированные данные.

Корректность данных – ключевая часть процесса. Если в CSV файле встречаются символы, не поддерживаемые в целевой базе данных, или строки, не соответствующие ожидаемым типам данных (например, текст в числовом поле), это приведет к ошибкам. Для предотвращения этого необходимо предварительно провести валидацию данных в CSV файле. Например, если столбец должен содержать только даты, проверьте, что все значения этого столбца соответствуют правильному формату (например, YYYY-MM-DD).

Приведение типов важно для соответствия типов данных между CSV и таблицей. Если, например, в CSV файл включены текстовые значения, которые предполагается хранить как числа, при импорте данных произойдет ошибка. В этом случае рекомендуется привести все данные к нужному типу до импорта. Если у вас есть возможность использовать скрипты для преобразования данных, это упростит задачу.

Обработка пропущенных значений должна быть предусмотрена заранее. В CSV файле могут быть пустые ячейки, которые при импорте могут быть интерпретированы как NULL или оставить строки с некорректными значениями. Некоторые СУБД позволяют указать значение по умолчанию для пропущенных ячеек, это помогает избежать ошибок. Если такое поведение не предусмотрено, необходимо заранее обработать данные в файле или добавить логику в SQL запрос для замены пустых значений на нужные.

Режим импорта также играет важную роль. Лучше всего использовать пакетные вставки (bulk insert), чтобы снизить нагрузку на сервер базы данных. Пакетные вставки позволяют уменьшить количество транзакций, что снижает вероятность возникновения ошибок, связанных с перегрузкой системы.

Логирование ошибок поможет в случае проблем с импортом. Некоторые СУБД предоставляют функционал для логирования ошибок в процессе импорта. Настройка этого механизма позволит вам быстро идентифицировать и исправить проблемные строки данных.

Тестовый импорт является обязательным этапом. Перед массовым импортом данных протестируйте процесс на небольшом наборе данных. Это поможет выявить возможные проблемы с форматами данных, типами столбцов и другим, что может вызвать ошибки в основной базе данных.

Включив эти меры в процесс импорта, вы значительно сократите вероятность ошибок и улучшите качество данных в вашей SQL таблице.

Использование утилит и скриптов для автоматизации импорта CSV в SQL

Для эффективного импорта данных из CSV файлов в базы данных SQL рекомендуется использовать утилиты и скрипты, которые обеспечивают автоматизацию этого процесса. Один из популярных способов – использование командных утилит, таких как mysqlimport для MySQL или psql для PostgreSQL, которые позволяют загружать данные из CSV без написания сложных скриптов.

Для MySQL можно использовать утилиту mysqlimport, которая выполняет импорты данных из CSV прямо из командной строки. Пример команды для импорта файла в таблицу:

mysqlimport --local --fields-terminated-by=',' --lines-terminated-by='\n' --user=root --password dbname /path/to/file.csv

Важно, чтобы файл CSV соответствовал структуре таблицы в базе данных, иначе потребуется предварительная настройка, включая установку правильных разделителей и форматов данных.

Для PostgreSQL аналогичный процесс можно автоматизировать через команду COPY, которая обеспечивает быстрый импорт данных. Пример команды:

COPY table_name FROM '/path/to/file.csv' DELIMITER ',' CSV HEADER;

Этот способ требует, чтобы файл CSV был доступен на сервере базы данных. Для выполнения операции можно использовать psql, что позволяет запускать команду прямо в терминале.

Если нужно обрабатывать данные перед загрузкой в базу, например, удалять или изменять некоторые записи, можно использовать Python и библиотеки, такие как pandas для чтения и обработки CSV, а затем импортировать данные через SQLAlchemy или psycopg2. Пример скрипта на Python для импорта данных в PostgreSQL:

import pandas as pd

from sqlalchemy import create_engine

# Чтение CSV файла

df = pd.read_csv('file.csv')

# Создание подключения к базе данных

engine = create_engine('postgresql://user:password@localhost/dbname')

# Импорт данных в таблицу

df.to_sql('table_name', engine, if_exists='replace', index=False)

Использование Python позволяет гибко обрабатывать данные перед импортом, например, для нормализации значений или добавления недостающих данных.

Кроме того, существует множество других инструментов для автоматизации, таких как Talend, Apache NiFi, которые обеспечивают визуальный интерфейс для настройки импорта данных. Эти инструменты подходят для более сложных случаев, когда требуется интеграция с несколькими источниками данных или использование сложных трансформаций перед загрузкой в базу.

Автоматизация с помощью скриптов и утилит позволяет значительно ускорить процесс импорта больших объемов данных, минимизировать ошибки и обеспечить постоянную актуальность данных в базе. Выбор инструмента зависит от конкретных требований проекта и уровня сложности обработки данных.

Как управлять дубликатами данных при импорте CSV в SQL

При импорте CSV в SQL важно учитывать возможные дубликаты данных, которые могут появляться как в исходном файле, так и в базе данных. Чтобы избежать некорректных записей, следует заранее разработать стратегии обработки дубликатов.

1. Использование уникальных индексов – Один из самых эффективных способов предотвратить добавление дубликатов в базу данных. Прежде чем импортировать данные, необходимо создать уникальный индекс для поля или набора полей, которые должны оставаться уникальными. Например, если данные содержат поле email, то добавление индекса на это поле гарантирует, что база данных не позволит вставить повторяющиеся адреса.

2. Проверка наличия дубликатов до импорта – Простой способ минимизировать риски дублирования – это выполнение проверки перед импортом. Например, при загрузке данных можно использовать запрос с условием, проверяющим, есть ли уже запись с таким же значением в базе данных. Если запись существует, она не будет добавлена. Это можно реализовать через команду INSERT IGNORE в MySQL или ON CONFLICT DO NOTHING в PostgreSQL.

3. Обработка дубликатов с помощью временных таблиц – Для более сложных случаев можно использовать временные таблицы. Вначале данные из CSV загружаются во временную таблицу, а затем выполняется операция слияния с основной таблицей с учетом уникальности записей. Для этого в SQL используется оператор MERGE (в некоторых СУБД это INSERT INTO … ON DUPLICATE KEY UPDATE). Это позволяет избежать дубликатов и сохранять только актуальные данные.

4. Использование инструментов ETL – В случае с большими объемами данных можно использовать специализированные инструменты ETL (Extract, Transform, Load), такие как Talend или Apache Nifi. Они предоставляют встроенные функции для обработки дубликатов, например, возможность на этапе трансформации удалять повторяющиеся строки.

5. Удаление дубликатов после импорта – Если дубликаты все же попали в базу данных, их можно удалить с помощью SQL-запроса. Например, используя конструкцию ROW_NUMBER() в сочетании с COVER BY, можно выделить только уникальные записи и удалить повторяющиеся. Пример запроса для удаления дубликатов:

WITH cte AS ( SELECT id, ROW_NUMBER() OVER (PARTITION BY email ORDER BY id) AS row_num FROM users ) DELETE FROM users WHERE id IN (SELECT id FROM cte WHERE row_num > 1);

6. Валидация данных перед загрузкой – Прежде чем загружать данные в базу данных, стоит провести их валидацию. Использование регулярных выражений или специализированных библиотек позволяет фильтровать неправильные или дублирующиеся значения. Например, можно проверить CSV на наличие одинаковых строк перед его загрузкой в базу.

7. Логирование и уведомления – Важно вести логирование операций импорта, чтобы в случае возникновения дубликатов можно было быстро обнаружить источник проблемы. Логирование позволяет отслеживать количество записей, которые были проигнорированы или отклонены из-за нарушений уникальности.

Решение проблем с кодировкой при импорте CSV в SQL

При импорте данных из CSV в базу данных SQL часто возникают проблемы с кодировкой символов. Наиболее распространённые ошибки включают некорректное отображение символов, замену их на «квадратики» или знаки вопроса, а также сбои при обработке данных с особыми символами (например, кириллицей). Чтобы избежать этих проблем, важно соблюдать несколько ключевых правил.

Первое, на что стоит обратить внимание, – это кодировка файла CSV. Стандартной кодировкой для SQL-серверов является UTF-8. Если CSV сохранён в другой кодировке (например, Windows-1251), данные могут быть некорректно интерпретированы при импорте. Для решения этой проблемы перед импортом нужно либо конвертировать файл в UTF-8, либо настроить SQL-сервер на использование исходной кодировки.

Для конвертации кодировки CSV в UTF-8 можно использовать текстовые редакторы (например, Notepad++) или командную строку. В Linux и macOS для этого подойдёт команда:

iconv -f windows-1251 -t utf-8 input.csv -o output.csv

Если требуется сохранить исходную кодировку файла, например, Windows-1251, важно убедиться, что SQL-сервер поддерживает её. В MySQL, например, можно указать кодировку при импорте с помощью команды:

LOAD DATA INFILE 'path_to_file.csv' INTO TABLE table_name CHARACTER SET 'cp1251' FIELDS TERMINATED BY ',' ENCLOSED BY '"' LINES TERMINATED BY '\n';

В PostgreSQL аналогичная задача решается с помощью параметра ENCODING:

COPY table_name FROM 'path_to_file.csv' WITH (FORMAT csv, ENCODING 'WIN1251');

Не менее важным является корректная настройка локализации базы данных. Базы данных часто имеют параметр lc_collate, который определяет правила сортировки и сравнения строк. Убедитесь, что локализация вашей базы данных совпадает с кодировкой входных данных, чтобы избежать некорректного сравнения строк с особыми символами.

Если импортируемые данные содержат специальные символы или могут быть в разных кодировках, рекомендуется сначала проверить файл на наличие таких символов, используя средства для работы с текстом, такие как регулярные выражения или утилиты для поиска нечитаемых символов.

Кроме того, следует помнить, что использование Unicode (UTF-8) значительно уменьшает вероятность возникновения ошибок при импорте и работе с данными, особенно если они содержат различные языки и символы.

В случае проблем с кодировкой при просмотре данных после импорта, можно проверить параметры соединения с базой данных. Например, в MySQL установите параметр character_set_client на UTF-8 перед выполнением запроса:

SET NAMES 'utf8';

Решение проблем с кодировкой требует внимательности на каждом этапе процесса импорта. Важно заранее проверять настройки и кодировки, чтобы избежать потери данных и искажений в текстовой информации.

Вопрос-ответ:

Как открыть CSV файл в базе данных SQL?

Чтобы открыть CSV файл в базе данных SQL, необходимо сначала загрузить файл в систему управления базой данных (СУБД). Процесс обычно начинается с создания таблицы, которая будет соответствовать структуре данных в CSV файле. Затем файл можно импортировать в таблицу с помощью команд или инструментов, предоставляемых СУБД. Например, в MySQL можно использовать команду LOAD DATA INFILE, в PostgreSQL — COPY. Важно, чтобы структура CSV файла совпадала с таблицей базы данных.

Какие шаги нужно предпринять для импорта CSV файла в SQL базу данных?

Процесс импорта CSV файла в SQL базу данных включает несколько шагов. Сначала создайте таблицу, которая будет соответствовать данным в CSV. Далее необходимо убедиться, что данные в CSV правильно структурированы, то есть разделены запятыми, а строки не содержат ошибок. После этого используйте команду импорта, которая зависит от используемой СУБД. В MySQL это может быть команда LOAD DATA INFILE, а в PostgreSQL — COPY. В некоторых случаях можно использовать инструменты GUI, такие как pgAdmin или MySQL Workbench, для упрощения процесса.

Какие проблемы могут возникнуть при импорте CSV файла в SQL базу данных?

При импорте CSV файла в SQL базу данных могут возникнуть различные проблемы. Одна из наиболее частых — несоответствие форматов данных. Например, текстовые данные могут содержать неожиданные символы или неправильные разделители, что приведет к ошибкам. Другой проблемой может быть наличие пустых строк или некорректных значений в CSV файле. Также может возникнуть ошибка, если структура CSV не совпадает с таблицей в базе данных, что требует проверки типов данных в обеих частях перед импортом.

Как исправить ошибки при импорте CSV файла в базу данных SQL?

Для исправления ошибок при импорте CSV файла в SQL базу данных нужно сначала проанализировать сообщение об ошибке. Если ошибка связана с типами данных, необходимо привести данные в файле к нужному формату или изменить типы данных в таблице базы. Если проблема в разделителе или кодировке, убедитесь, что используемый разделитель (например, запятая или точка с запятой) совпадает с тем, что указано в CSV, и что файл сохранен в правильной кодировке (например, UTF-8). Также полезно проверять на наличие пустых или некорректных строк в файле.

Как можно ускорить процесс импорта CSV файла в базу данных SQL?

Чтобы ускорить процесс импорта CSV файла в SQL базу данных, можно воспользоваться несколькими методами. Во-первых, стоит отключить индексы на время импорта, чтобы избежать их пересоздания для каждой строки. Во-вторых, если возможно, импортировать данные пакетами, а не строка за строкой, что позволяет значительно уменьшить время обработки. Также полезно использовать встроенные функции для массового импорта, такие как LOAD DATA INFILE в MySQL или COPY в PostgreSQL. Важно также убедиться, что файл CSV не содержит лишних данных и имеет оптимальный размер для обработки.

Как открыть CSV файл и импортировать его в базу данных SQL?

Чтобы открыть CSV файл и импортировать его в базу данных SQL, нужно выполнить несколько шагов. Сначала убедитесь, что файл сохранен в нужном формате (обычно с расширением .csv). Далее в SQL базе данных используйте команду импорта. Например, в MySQL можно использовать команду `LOAD DATA INFILE`, указав путь к файлу, или же через команду `COPY` в PostgreSQL. Также можно использовать графические интерфейсы для управления базами данных, такие как phpMyAdmin или pgAdmin, которые позволяют выполнить импорт файла через визуальный интерфейс. Важно также убедиться, что структура таблицы в базе данных соответствует данным в CSV файле, чтобы избежать ошибок при импорте.

Какие ошибки могут возникнуть при импорте CSV файла в базу данных SQL и как их избежать?

При импорте CSV файла в базу данных SQL могут возникнуть несколько типов ошибок. Одной из распространенных является несоответствие структуры данных в CSV файле и таблице базы данных. Например, если в CSV есть дополнительные столбцы или отсутствуют значения в некоторых ячейках, это может привести к сбоям при импорте. Чтобы избежать таких ошибок, нужно заранее проверить соответствие формата данных и структуры таблицы. Также важно убедиться, что данные в CSV файле не содержат символов, которые могут быть интерпретированы как команды SQL (например, одинарные кавычки в строках). В некоторых случаях помогает предварительная очистка данных в CSV файле с помощью Excel или текстового редактора.