Для создания эффективной инфографики из статистических данных необходимо правильно собрать и подготовить информацию. SQL – это мощный инструмент для извлечения, обработки и агрегации данных, который позволяет преобразовать сырьё в наглядные визуальные представления. Важно не только получить данные, но и правильно их агрегировать, чтобы они были представлены в удобном и понятном виде. В этой статье мы рассмотрим основные подходы к сбору статистики с помощью SQL для последующего использования в инфографике.

Первым шагом на пути к созданию инфографики является определение целей визуализации. В SQL важно точно формулировать запросы, которые помогут выявить ключевые показатели: будь то количество пользователей, средняя сумма покупок или распределение времени. Использование агрегирующих функций, таких как SUM(), COUNT(), AVG() или GROUP BY, позволяет строить агрегированные данные, которые станут основой для создания наглядных диаграмм и графиков.

После того как данные собраны, необходимо позаботиться о их точности и полноте. Не стоит игнорировать фильтрацию данных с помощью WHERE, а также проверку на наличие пропусков или аномальных значений. Если ваши данные требуют фильтрации по времени или конкретным сегментам (например, по регионам или категориям товаров), то грамотная настройка запросов с помощью JOIN или CASE поможет избежать ошибок в финальной инфографике.

Наконец, важно помнить, что статистика в виде инфографики должна быть не только точной, но и легко воспринимаемой. SQL помогает выстраивать логику обработки данных, но для визуализации потребуется перевод результатов запросов в формат, который поддерживает ваше средство визуализации (например, JSON или CSV). Поэтому правильная подготовка данных в SQL – это ключ к созданию не только информативной, но и эстетически привлекательной инфографики.

Подготовка данных для визуализации: выбор таблиц и фильтрация информации

Для создания эффективной инфографики важна правильная подготовка данных. Это начинается с выбора подходящих таблиц и фильтрации информации. Неправильный выбор источников данных может привести к некачественным или нерелевантным результатам.

Основные этапы подготовки данных включают:

- Анализ требований к визуализации – перед началом работы важно понять, какие показатели должны быть представлены. Например, для анализа продаж потребуются данные о количестве проданных товаров, стоимости, времени и географическом распределении.

- Выбор таблиц и источников данных – исходя из целей визуализации, нужно выбрать таблицы, которые содержат нужную информацию. Например, для анализа клиентов можно использовать таблицы с данными о покупках и информации о клиентах (имя, возраст, регион и т.д.).

- Определение ключевых полей – в каждой таблице выделяются столбцы, которые будут основными для анализа. В таблице с заказами это может быть ID заказа, дата, сумма заказа. В таблице с клиентами – ID клиента, возраст, регион.

Для фильтрации информации, чтобы избежать избыточности или неверных данных, можно использовать следующие подходы:

- Фильтрация по временным интервалам – часто важно ограничить выборку определенным периодом. Пример SQL-запроса:

SELECT * FROM sales WHERE sale_date BETWEEN '2024-01-01' AND '2024-03-31';. - Фильтрация по категориям данных – если необходимо анализировать только определенную категорию товаров или клиентов, можно добавить фильтр по соответствующему столбцу. Пример:

SELECT * FROM products WHERE category = 'electronics';. - Удаление дублирующихся данных – перед визуализацией важно очистить данные от повторяющихся записей. Это можно сделать с помощью оператора

DISTINCT:SELECT DISTINCT product_id FROM sales;.

После выполнения фильтрации необходимо удостовериться, что данные полноценно соответствуют требованиям задачи. Это может включать проверку на пропуски значений или аномалии, которые могут исказить результаты визуализации.

Агрегирование данных: использование функций COUNT, SUM, AVG и других

Агрегирование данных позволяет эффективно обрабатывать большие объемы информации, предоставляя сводные показатели, которые полезны для анализа и визуализации. В SQL для этого используются функции, такие как COUNT, SUM, AVG, MIN, MAX и другие, каждая из которых решает конкретные задачи в зависимости от типа данных и целей анализа.

Функция COUNT подсчитывает количество строк, удовлетворяющих заданным условиям. Например, запрос SELECT COUNT(*) FROM sales WHERE amount > 100 вернет количество продаж, где сумма больше 100 единиц. Это удобно для анализа частоты событий или подсчета записей в базе данных.

Функция SUM вычисляет сумму значений в выбранной колонке. Например, запрос SELECT SUM(amount) FROM sales WHERE region = 'North' возвращает общую сумму продаж по региону «North». SUM полезна для подсчета общей величины денежных поступлений, расходов или других количественных данных.

Для вычисления средней величины используется функция AVG. Запрос SELECT AVG(amount) FROM sales вернет среднюю сумму по всем записям в таблице. Эта функция помогает выявить тренды или общие параметры, такие как средний чек или средний возраст клиентов.

Функции MIN и MAX позволяют найти минимальное и максимальное значение в наборе данных. Пример запроса SELECT MIN(amount) FROM sales возвращает минимальную сумму продажи, а SELECT MAX(amount) FROM sales – максимальную. Эти функции полезны для выявления крайних значений в анализируемых данных.

Кроме стандартных агрегатных функций, в SQL можно использовать комбинации этих функций с операторами GROUP BY и HAVING для более детального анализа. Например, запрос SELECT region, SUM(amount) FROM sales GROUP BY region вычислит сумму продаж по каждому региону. При этом условие HAVING SUM(amount) > 10000 позволит отфильтровать регионы с суммой продаж ниже 10 000 единиц.

В случаях, когда необходимо агрегировать данные по временным периодам или категориям, полезно использовать DATE_TRUNC или подобные функции для группировки по дням, месяцам, кварталам или годам. Это позволяет выделить тренды и сезонные колебания, например: SELECT DATE_TRUNC('month', sale_date), SUM(amount) FROM sales GROUP BY DATE_TRUNC('month', sale_date).

Сочетание этих функций и методов агрегации помогает строить точные и информативные инфографики, которые могут быть использованы для анализа бизнес-процессов, мониторинга эффективности или прогнозирования будущих трендов.

Преобразование данных для инфографики с помощью GROUP BY

Применение GROUP BY позволяет выделить паттерны и изменения в данных, что важно для дальнейшей визуализации. Например, если необходимо показать распределение продаж по регионам, запрос с GROUP BY сгруппирует все записи по региону, после чего можно посчитать количество продаж или их общую сумму для каждого региона.

При использовании GROUP BY важно учитывать порядок операций. Сначала происходит группировка данных, затем применяются агрегатные функции. Пример запроса:

SELECT region, COUNT(sale_id) AS total_sales FROM sales GROUP BY region;

Этот запрос даст количество продаж по каждому региону. Такие данные можно использовать для создания диаграммы или карты, показывающей активность в разных частях страны или мира.

Для создания более сложной инфографики можно использовать несколько уровней группировки. Например, для отображения продаж по месяцам и регионам, можно добавить ещё одну группу:

SELECT region, EXTRACT(MONTH FROM sale_date) AS month, SUM(amount) AS total_sales FROM sales GROUP BY region, month;

Такой запрос поможет визуализировать не только общие данные по регионам, но и динамику продаж в течение времени. Визуализация этих данных позволяет отслеживать сезонные колебания и выявлять тенденции.

HAVING – это ещё одна полезная функция при использовании GROUP BY, которая позволяет фильтровать агрегированные результаты. Например, если необходимо показать только те регионы, где продажи превышают определённый порог, можно добавить условие:

SELECT region, SUM(amount) AS total_sales FROM sales GROUP BY region HAVING SUM(amount) > 10000;

Это поможет исключить из отчёта регионы с низкими продажами, фокусируя внимание на более прибыльных зонах. Такой подход повышает значимость инфографики, выделяя ключевые данные.

Для создания инфографики также важно учитывать соответствие типов данных в группах. Если в группировку попадают нечисловые данные (например, текстовые поля), следует внимательно выбирать агрегатные функции. Например, COUNT работает и с текстовыми полями, что позволяет подсчитать количество уникальных значений.

В завершение стоит отметить, что использование GROUP BY в SQL не только упрощает обработку данных, но и даёт возможность строить чёткие и информативные визуализации, ориентированные на ключевые показатели.

Оптимизация запросов для работы с большими объемами данных

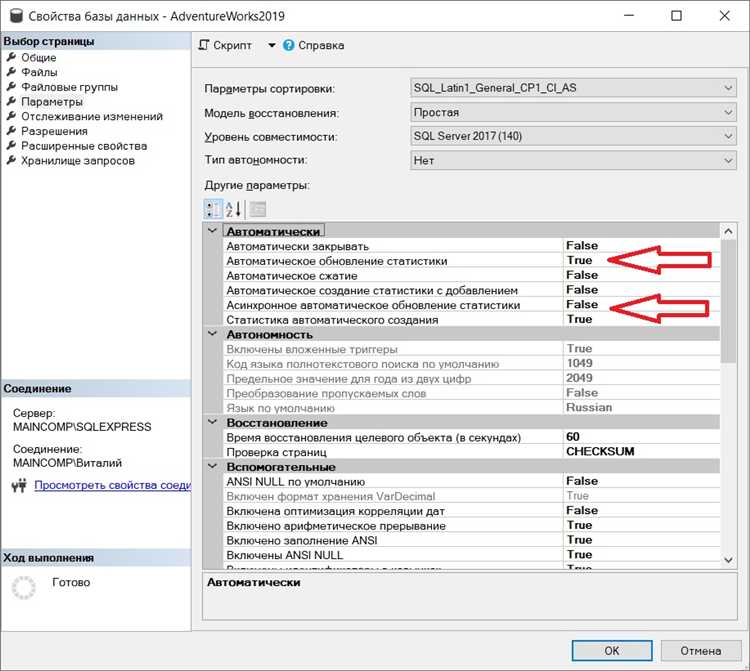

Работа с большими объемами данных требует тщательной настройки запросов для обеспечения высокой производительности. Использование неправильных подходов может привести к значительному снижению скорости работы и увеличению времени обработки запросов. Чтобы минимизировать эти риски, следует применить несколько эффективных методов оптимизации.

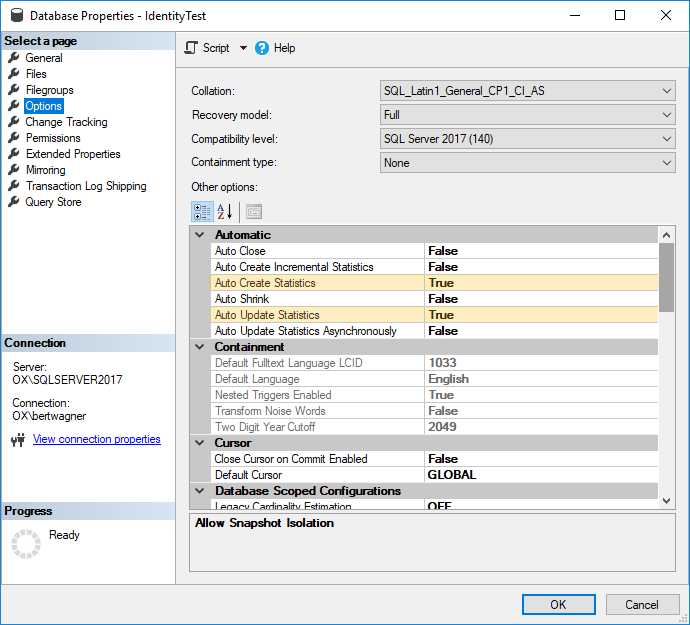

- Индексы. Создание индексов на часто используемые столбцы позволяет значительно ускорить выполнение запросов, особенно для операций поиска, сортировки и объединения таблиц. Однако стоит помнить, что избыточное количество индексов может замедлить операции вставки и обновления данных.

- Использование агрегатных функций с учетом индексов. При работе с большими объемами данных полезно использовать агрегатные функции (например,

COUNT(),SUM(),AVG()) в сочетании с индексами. Это позволяет избежать полного сканирования таблиц, что ускоряет обработку. - Разбиение таблиц (sharding). Разбиение данных на несколько меньших таблиц позволяет ускорить запросы за счет уменьшения объема обрабатываемых данных в каждом запросе. Это особенно полезно в распределенных системах.

- Использование «пагинации». Когда необходимо обрабатывать большие объемы данных и отображать их постранично, пагинация (

LIMIT,OFFSET) помогает разделить запросы на более мелкие части, уменьшая нагрузку на систему. - Оптимизация подзапросов. Часто подзапросы можно заменить на соединения, что позволит SQL-серверу более эффективно использовать индексы и уменьшить количество операций. Например, использование

JOINвместо подзапросов может значительно ускорить выполнение запросов. - Использование аналитических функций. Аналитические функции (например,

ROW_NUMBER(),RANK(),LEAD()) позволяют выполнять сложные операции по данным, не требующие дополнительных подзапросов, что улучшает производительность на больших объемах данных. - Параллельная обработка запросов. В случае работы с огромными объемами данных стоит рассмотреть возможность использования параллельных запросов. Это можно реализовать на уровне базы данных, если она поддерживает параллельное выполнение запросов (например, в PostgreSQL или SQL Server).

- Кэширование результатов. Важно кэшировать результаты часто выполняемых запросов, чтобы избежать их повторного выполнения на больших данных. Использование встроенных механизмов кэширования или внешних кэш-систем (например, Redis) позволяет существенно снизить нагрузку на сервер.

- Оптимизация структуры данных. Применение нормализации или денормализации данных в зависимости от конкретных сценариев использования может значительно повлиять на производительность запросов. Например, для часто используемых отчетов может быть полезно использовать денормализованные таблицы.

- Мониторинг и анализ выполнения запросов. Регулярный мониторинг выполнения запросов с помощью инструментов профилирования (например, EXPLAIN в PostgreSQL) позволяет выявить узкие места и определить, какие части запросов требуют улучшений. Важно отслеживать частоту использования индексов и время выполнения операций.

Эти рекомендации помогают значительно повысить производительность при работе с большими объемами данных в SQL, обеспечивая более быстрые и эффективные запросы.

Преобразование числовых данных в категории для визуализации

Для преобразования числовых данных в категории можно использовать диапазоны. Например, если нужно сгруппировать возраст клиентов по категориям, можно создать условие, которое разделяет все значения на группы: «молодежь» (от 18 до 30 лет), «средний возраст» (от 31 до 50 лет), «пожилые» (от 51 года и старше). Это можно реализовать с помощью SQL-запроса:

SELECT CASE WHEN age BETWEEN 18 AND 30 THEN 'Молодежь' WHEN age BETWEEN 31 AND 50 THEN 'Средний возраст' WHEN age >= 51 THEN 'Пожилые' ELSE 'Неизвестно' END AS age_group FROM customers;

Если значения числовых данных представляют собой последовательности, можно использовать категориальные группы, основанные на квантилях. Например, для создания групп по доходу, можно разделить всех клиентов на несколько равных по числу групп, такие как «Низкий доход», «Средний доход» и «Высокий доход». Для этого можно воспользоваться функцией `NTILE()`:

SELECT income, NTILE(3) OVER (ORDER BY income) AS income_group FROM customers;

Еще один распространенный способ – это преобразование чисел в бинарные категории. Например, можно отнести пользователей к группе «Активные» или «Неактивные» на основе их покупок, разделяя их на тех, кто совершил покупку за последний месяц, и тех, кто не совершал покупок. Для этого используется простая логика с условием:

SELECT CASE WHEN last_purchase_date >= CURRENT_DATE - INTERVAL '1 month' THEN 'Активные' ELSE 'Неактивные' END AS user_status FROM users;

Визуализируя такие категории, можно использовать цветовые схемы, где каждый диапазон или группа отображается разным цветом. Это позволяет быстро воспринять и проанализировать тенденции, такие как возрастные или доходные группы, а также выявить закономерности в поведении пользователей.

Важно помнить, что правильный выбор категорий зависит от контекста анализа. Излишне широкие или узкие категории могут исказить результаты, а также усложнить восприятие инфографики. Чем точнее и логичнее категории, тем легче будет воспринимать информацию и принимать решения на основе данных.

Использование подзапросов для подготовки комплексных статистических данных

Подзапросы можно использовать в различных частях SQL-запроса: в блоках SELECT, WHERE, FROM, а также в операторах HAVING. В контексте инфографики и статистики подзапросы обеспечивают гибкость при агрегировании и фильтрации данных, что критично для подготовки аналитики на основе нескольких уровней информации.

Для примера, представим, что нужно построить график распределения продаж по категориям товаров за последний месяц, но с дополнительным фильтром, учитывающим только те категории, которые принесли больше 50% от общего объема продаж. Для этого можно использовать подзапрос, чтобы сначала вычислить общий объем продаж, а затем сравнить продажи каждой категории с этим значением.

SELECT category_id, SUM(sales) AS category_sales FROM sales WHERE sale_date BETWEEN '2025-03-01' AND '2025-03-31' GROUP BY category_id HAVING SUM(sales) > ( SELECT SUM(sales) * 0.5 FROM sales WHERE sale_date BETWEEN '2025-03-01' AND '2025-03-31' );

В данном примере подзапрос в части HAVING рассчитывает общий объем продаж за месяц и фильтрует категории, чьи продажи превышают 50% от этого значения. Такой подход позволяет эффективно обрабатывать данные без необходимости создавать промежуточные таблицы или выполнять несколько запросов.

Для более сложных статистических данных, таких как вычисление медианных значений или определение аномальных показателей, подзапросы могут быть использованы для предварительного отбора данных. Например, для подсчета медианного значения продаж по каждому региону можно использовать подзапрос, который определяет медиану для каждого набора данных.

Кроме того, подзапросы часто применяются для объединения данных из нескольких таблиц, что позволяет строить статистику на основе различных источников данных, например, комбинируя информацию о клиентах и их покупках или отслеживая изменения по временным периодам.

Таким образом, подзапросы значительно расширяют возможности SQL для подготовки статистики и инфографики, позволяя строить сложные аналитические запросы, сводить и фильтровать данные с минимальными затратами на вычисления.

После того как данные собраны с помощью SQL-запросов, важно правильно подготовить их для экспорта в инструменты визуализации, такие как Power BI, Tableau, Google Data Studio и другие. На этом этапе ключевыми задачами становятся выбор формата и оптимизация данных для последующего анализа и графического представления.

Одним из наиболее популярных форматов для экспорта является CSV (Comma-Separated Values), который легко импортируется в большинство инструментов визуализации. Для генерации CSV-файлов с помощью SQL можно использовать команду SELECT INTO OUTFILE (для MySQL) или COPY TO (для PostgreSQL). Эти команды позволяют выгрузить результат запроса непосредственно в файл, что существенно ускоряет процесс и уменьшает вероятность ошибок при ручном экспорте.

Для улучшения качества визуализации и предотвращения ошибок данных, перед экспортом стоит выполнить агрегацию и фильтрацию информации в самом SQL-запросе. Использование функций GROUP BY и HAVING поможет свести данные к нужному уровню детализации. Например, если необходимо построить график продаж по месяцам, стоит заранее агрегировать данные по месяцам с помощью GROUP BY YEAR, MONTH для точности и скорости работы инструмента визуализации.

Некоторые инструменты визуализации, такие как Tableau, поддерживают прямое подключение к базе данных через ODBC или JDBC. В этом случае SQL-запросы можно запускать непосредственно из интерфейса инструмента, что избавляет от необходимости экспортировать файлы. Важно помнить, что при таком подходе нужно оптимизировать запросы для минимизации нагрузки на сервер, особенно если речь идет о работе с большими объемами данных.

При подготовке данных для экспорта также стоит учесть правильное форматирование числовых и текстовых значений. Например, использование FORMAT() для чисел в SQL позволяет избежать проблем с отображением данных в визуализаторах, где требуется строгий формат. В случае с текстами стоит проверять кодировку данных, чтобы избежать проблем с отображением символов при импорте.

Кроме того, перед экспортом данных всегда полезно провести их предварительный анализ и очистку. Проверка на наличие пустых значений, дубликатов или аномальных данных поможет избежать некорректных визуализаций. Для этого в SQL можно использовать такие функции, как COALESCE() для замены пустых значений и DISTINCT для удаления дубликатов.

В результате правильной подготовки данных, их экспорта и последующего использования в инструментах визуализации можно получить качественные, информативные и удобные отчеты, которые будут максимально полезны для анализа и принятия решений.

Вопрос-ответ:

Какие данные можно использовать для создания инфографики с помощью SQL?

Для создания инфографики с помощью SQL можно использовать любые данные, которые хранятся в базе данных. Это могут быть таблицы с информацией о продажах, клиентах, продуктах, событиях или других метках. Важно, чтобы данные были структурированы и содержали числовые показатели, которые могут быть агрегированы или отфильтрованы для визуализации, например, количество продаж по месяцам или средний доход по регионам.

Как подготовить данные для инфографики с помощью SQL?

Подготовка данных для инфографики с помощью SQL начинается с очистки данных и их агрегирования. На этом этапе важно убедиться, что в таблицах нет ошибок, дублирующихся записей или ненужных значений. Затем нужно агрегировать данные, например, по месяцам или категориям, чтобы они были более удобными для визуализации. Запросы с GROUP BY и фильтрами WHERE могут помочь выделить нужные сегменты. Например, можно сделать запрос для того, чтобы посчитать среднее значение по регионам или товарным категориям, что удобно для инфографики, отображающей сравнительные данные.

Какие инструменты можно использовать для визуализации данных, полученных с помощью SQL?

Для визуализации данных, собранных с помощью SQL, можно использовать различные инструменты, такие как Power BI, Tableau, Google Data Studio, а также библиотеки для программирования, например, Matplotlib или Seaborn в Python. Эти инструменты позволяют импортировать данные из базы данных и создавать графики, диаграммы и другие виды инфографики. Они поддерживают подключение к SQL-серверам и предлагают простые способы работы с данными, что делает процесс визуализации удобным и гибким.