Spark SQL – это компонент фреймворка Apache Spark, предназначенный для работы с данными в структуре таблиц с использованием SQL-подобных запросов. Он предоставляет интерфейс для выполнения SQL-запросов на больших объемах данных, что делает его важным инструментом для аналитиков и инженеров данных. Spark SQL позволяет работать как с традиционными реляционными базами данных, так и с данными, хранящимися в распределенных файловых системах, таких как HDFS и S3.

Основной особенностью Spark SQL является его способность эффективно интегрировать SQL-запросы с кодом на языке программирования, например, Python или Scala. В отличие от традиционных SQL-баз данных, Spark SQL работает в распределенной среде, что позволяет значительно ускорить обработку больших наборов данных. Это достигается за счет использования распределенных вычислений и оптимизации через план выполнения, встроенную в ядро Spark.

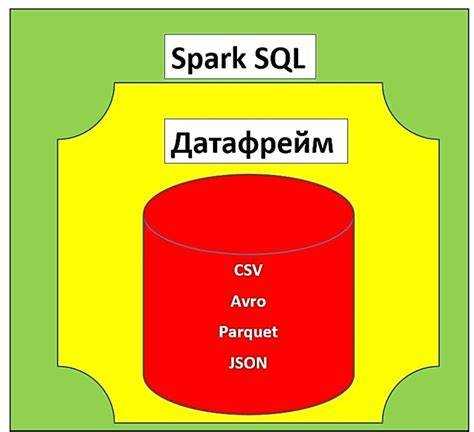

Одним из ключевых преимуществ Spark SQL является поддержка разных источников данных через абстракцию DataFrame. DataFrame представляет собой структуру данных, которая напоминает таблицу в реляционной базе данных, и поддерживает операции фильтрации, агрегации и объединения. Благодаря интеграции с библиотеками Spark, такими как MLlib и GraphX, Spark SQL позволяет не только выполнять классические SQL-запросы, но и работать с машинным обучением и графовыми вычислениями прямо в одном процессе обработки.

Кроме того, Spark SQL поддерживает Catalyst Optimizer, который автоматически оптимизирует запросы, обеспечивая минимальное время выполнения. Это важный аспект, так как в мире больших данных производительность обработки может значительно варьироваться в зависимости от структуры и объема исходных данных. Catalyst позволяет улучшить скорость работы запросов без необходимости вручную оптимизировать код.

Как Spark SQL позволяет работать с большими данными

Spark SQL предоставляет мощный интерфейс для обработки больших объемов данных, используя знакомый синтаксис SQL. Это достигается благодаря интеграции с Apache Spark, распределённой вычислительной платформой, которая позволяет обрабатывать данные, распределённые по нескольким узлам кластера. Основная цель Spark SQL – оптимизация обработки данных за счёт параллельных вычислений и использования различных форматов хранения данных, таких как Parquet и ORC, которые эффективно поддерживают сжатие и индексацию данных.

Для работы с большими данными Spark SQL использует Catalyst – оптимизатор запросов, который автоматически преобразует SQL-запросы в более эффективные планы исполнения. Catalyst анализирует запросы, выполняя их оптимизацию на нескольких уровнях, включая выбор стратегии соединений (например, хэш-соединение или сортировка) и минимизацию затрат на выполнение запросов. Это позволяет значительно ускорить обработку запросов на больших наборах данных.

Благодаря использованию формата DataFrame, Spark SQL позволяет работать с данными в удобной и абстрактной форме. DataFrame обеспечивает высокую производительность за счёт операций в памяти и минимизации необходимости чтения данных с диска. DataFrame можно использовать как с SQL-запросами, так и с программными интерфейсами, что даёт разработчикам гибкость в выборе инструментов для решения различных задач анализа данных.

Также Spark SQL позволяет использовать широкие возможности для обработки данных в реальном времени. Благодаря интеграции с Spark Streaming, можно выполнять запросы SQL к потоку данных, обеспечивая их динамическую обработку и анализ в режиме реального времени. Это даёт возможность работать с большими потоками данных, такими как журналы серверов или данные сенсоров, обеспечивая их немедленную обработку и анализ.

Кроме того, Spark SQL поддерживает взаимодействие с различными источниками данных, включая HDFS, Apache Hive, Apache HBase и другие. Это даёт возможность интегрировать данные, хранящиеся в различных системах, в единую аналитическую платформу и обеспечивать их обработку без необходимости их предварительного перемещения или преобразования. Использование Spark SQL позволяет анализировать данные, которые могут быть распределены по огромному количеству узлов и кластеров, что делает его идеальным инструментом для обработки очень больших данных.

Основные операции в Spark SQL: от фильтрации до агрегации

Фильтрация в Spark SQL осуществляется с помощью оператора filter или SQL-запроса с использованием условия WHERE. Например, для выборки строк, где значения в столбце «age» больше 30, используется следующий запрос:

SELECT * FROM people WHERE age > 30;В Spark DataFrame можно выполнить фильтрацию через API:

df.filter(df['age'] > 30)Фильтрация – это базовая операция, которая часто используется при работе с большими наборами данных для выделения только релевантных строк.

После фильтрации часто выполняется операция выборки, где можно ограничить количество возвращаемых строк с помощью метода limit. Например, если нужно выбрать только 10 строк:

SELECT * FROM people LIMIT 10;В Spark SQL также есть возможность выбирать отдельные столбцы, что позволяет снизить нагрузку при работе с большими данными. Это можно сделать с помощью оператора SELECT или метода select для DataFrame:

df.select("name", "age")Агрегация данных – ещё одна важная операция. В Spark SQL можно выполнять агрегацию с использованием стандартных SQL-функций, таких как COUNT, SUM, AVG, MIN и MAX. Например, чтобы посчитать количество людей в каждой возрастной категории, можно использовать следующий запрос:

SELECT age, COUNT(*) FROM people GROUP BY age;В API Spark можно выполнить аналогичную операцию с использованием метода groupBy:

df.groupBy("age").count()SELECT age, COUNT(*) FROM people GROUP BY age HAVING COUNT(*) > 5;Сортировка данных является ещё одной часто используемой операцией. Для этого используется оператор ORDER BY в SQL или метод orderBy в API Spark:

df.orderBy("age")Можно сортировать данные по нескольким столбцам или указать направление сортировки (по возрастанию или убыванию). Например, сортировка по возрасту и имени:

df.orderBy("age", "name")Все эти операции – фильтрация, выборка, агрегация и сортировка – являются основными инструментами для работы с данными в Spark SQL и являются основой для построения сложных запросов и аналитических процессов.

Использование DataFrame API для обработки данных в Spark SQL

DataFrame API в Spark SQL предоставляет удобный и высокоуровневый интерфейс для работы с данными в распределённых вычислениях. Это мощный инструмент, позволяющий обрабатывать данные в виде таблиц с возможностью выполнения SQL-запросов и применения различных операций преобразования.

Основное преимущество использования DataFrame API заключается в абстракции, которая скрывает детали распределённой обработки данных. DataFrame представляет собой структуру данных, которая включает в себя колонки и строки, и может быть обработан с использованием стандартных методов API для фильтрации, агрегации, объединений и других операций.

Создание DataFrame начинается с загрузки данных из различных источников, таких как файлы CSV, JSON, базы данных или HDFS. Для этого достаточно использовать методы, такие как spark.read.csv() или spark.read.json(), что позволяет легко интегрировать различные форматы данных в процесс обработки. Например:

val df = spark.read.option("header", "true").csv("path/to/file.csv")После создания DataFrame, Spark SQL предоставляет доступ к широкому набору функций для манипуляции данными. Одной из основных операций является фильтрация данных. Метод filter() позволяет отбирать строки, соответствующие заданным условиям. Например:

val filteredDF = df.filter(df("age") > 30)Для выполнения агрегаций, таких как вычисление средней или максимальной величины, используется метод groupBy() в сочетании с агрегационными функциями, такими как avg() или max(). Пример:

val avgAgeDF = df.groupBy("city").avg("age")В Spark SQL можно также выполнять объединения (join) DataFrame с использованием различных типов соединений: inner join, outer join, left join и так далее. Пример объединения двух DataFrame:

val joinedDF = df1.join(df2, df1("id") === df2("id"), "inner")Особенность DataFrame API в Spark заключается в том, что он поддерживает оптимизацию выполнения через механизм Catalyst. Это означает, что Spark автоматически анализирует запросы и применяет оптимизации, такие как переупорядочивание операций или удаление ненужных шагов, для улучшения производительности.

Использование Spark SQL с DataFrame API позволяет выполнять SQL-запросы прямо на DataFrame. Для этого используется метод spark.sql(), который позволяет писать стандартные SQL-запросы, обращаясь к данным, загруженным в DataFrame. Например:

df.createOrReplaceTempView("people")

val sqlDF = spark.sql("SELECT age, city FROM people WHERE age > 30")Таким образом, DataFrame API предоставляет гибкость и эффективность при обработке данных, обеспечивая баланс между декларативным SQL-стилем и программной логикой на уровне API. Использование Spark SQL с DataFrame API позволяет интегрировать обработку больших данных в современные приложения с минимальными затратами на обучение и освоение новых технологий.

Как Spark SQL интегрируется с различными источниками данных

Spark SQL предоставляет мощные возможности для работы с данными из разных источников благодаря встроенным коннекторам и поддержке множества форматов данных. Интеграция с внешними системами позволяет обрабатывать данные в реальном времени и анализировать большие объемы информации с использованием SQL-подобного синтаксиса. Рассмотрим, как Spark SQL работает с наиболее популярными источниками данных.

- HDFS – Spark SQL поддерживает работу с данными, хранящимися в Hadoop Distributed File System. Для этого используются специальные коннекторы, позволяющие загружать и обрабатывать данные в форматах Parquet, Avro, ORC и других. Это дает возможность Spark SQL эффективно работать с большими данными и выполнять распределенные SQL-запросы.

- Реляционные базы данных – Через JDBC и ODBC драйверы Spark SQL интегрируется с популярными реляционными СУБД, такими как MySQL, PostgreSQL, Oracle и другими. Это позволяет загружать данные с помощью SQL-запросов и использовать их для дальнейшего анализа и агрегации в Spark.

- NoSQL базы данных – Spark SQL поддерживает работу с NoSQL системами, такими как Apache Cassandra, MongoDB и HBase. Для каждого типа базы данных существует специальный коннектор, который оптимизирует процесс извлечения и записи данных, обеспечивая производительность и масштабируемость при работе с большими объемами данных.

- Amazon S3 и другие облачные хранилища – С помощью коннекторов для облачных хранилищ, таких как Amazon S3, Google Cloud Storage или Azure Blob Storage, Spark SQL может читать и записывать данные прямо в облаке. Это важно для работы с распределенными данными и в сценариях, когда данные хранятся в облачных платформах.

- Kafka – Для обработки потоковых данных Spark SQL интегрируется с Apache Kafka. Это позволяет читать сообщения из Kafka и обрабатывать их в реальном времени с помощью SQL-запросов. Такой подход идеально подходит для анализа данных из IoT устройств, логов и других источников с высокой частотой обновлений.

- Hive – Spark SQL тесно интегрируется с Apache Hive, что позволяет использовать существующие Hive таблицы и метаданные. При этом Spark SQL может выполнять SQL-запросы к данным, хранящимся в HDFS, с использованием Hive-синтаксиса, что облегчает миграцию с Hive на Spark.

Для эффективной работы с различными источниками данных важно выбирать оптимальные коннекторы и настройки для конкретных задач. Например, при работе с большими объемами данных в HDFS рекомендуется использовать формат Parquet, который обеспечивает высокую степень сжатия и быстроту обработки. При взаимодействии с реляционными базами данных стоит учитывать особенности конфигурации JDBC-драйверов для минимизации задержек при извлечении данных.

Оптимизация запросов в Spark SQL: методы и подходы

Одним из наиболее эффективных методов оптимизации является использование оператора broadcast. Этот метод позволяет избежать дорогостоящих операций shuffle, передавая небольшие данные в память каждого узла, что значительно снижает время выполнения запроса при работе с малыми таблицами в операциях соединения.

Другим важным аспектом является использование партиционирования данных. Если данные распределены по различным разделам, можно уменьшить объем данных, обрабатываемых на каждом узле. Использование правильных ключей партиционирования позволяет снизить время выполнения запросов, особенно в случае операций агрегации и join.

Важным инструментом является кеширование данных. Spark SQL поддерживает кэширование промежуточных результатов с помощью методов cache() и persist(). Эти методы позволяют избежать повторных вычислений на больших наборах данных, ускоряя выполнение последующих запросов, которые используют уже обработанные данные.

Для улучшения производительности также полезно использовать предсказуемые типы данных и избегать чрезмерного использования сложных операций, таких как cross join, которые могут привести к экспоненциальному росту объема обрабатываемых данных. Важно также использовать подходы к сжатию данных и выбирать оптимальные форматы хранения, такие как Parquet или ORC, которые предоставляют преимущества в скорости и размере при работе с данными в Spark SQL.

В дополнение, следует обратить внимание на использование explain() для анализа выполнения запросов. Этот инструмент предоставляет подробное описание плана выполнения запроса, что помогает выявить узкие места и оптимизировать их, например, заменив полные сканирования таблиц на индексацию или перераспределение данных.

Разработка и выполнение пользовательских функций в Spark SQL

В Spark SQL возможность разработки и использования пользовательских функций (UDF) значительно расширяет функционал обработки данных. UDF позволяют интегрировать специфические вычисления и преобразования, которые невозможно реализовать с использованием стандартных функций SQL. Разработка пользовательских функций в Spark SQL включает создание функций на языке программирования, таких как Java, Scala, Python или R, и их регистрацию в Spark-сессии.

Для создания пользовательской функции нужно написать её логику, а затем зарегистрировать в Spark SQL. Например, для реализации функции на Python используется библиотека PySpark. После написания самой функции её необходимо обернуть в UDF, что позволит использовать её в запросах SQL. Функция может принимать один или несколько аргументов и возвращать результат, который будет обработан Spark SQL как стандартное значение.

Пример создания и регистрации UDF в PySpark:

from pyspark.sql.functions import udf

from pyspark.sql.types import IntegerType

# Определение функции

def add_one(x):

return x + 1

# Регистрация UDF

add_one_udf = udf(add_one, IntegerType())

# Применение UDF в DataFrame

df = df.withColumn("new_column", add_one_udf(df["column"]))

Регистрация функции с использованием udf() позволяет эффективно интегрировать её в дальнейшую обработку данных. Важно помнить, что пользовательские функции могут значительно замедлить выполнение запросов, так как они выполняются на уровне ядра, а не оптимизируются с помощью Catalyst, как стандартные SQL-функции.

Для повышения производительности рекомендуется использовать встроенные функции Spark SQL, когда это возможно. Однако в случае, если функционал Spark SQL не покрывает всех требований, UDF предоставляет необходимую гибкость для расширения возможностей обработки данных.

Кроме того, Spark SQL поддерживает создание пользовательских агрегатных функций (UDAF), что позволяет использовать пользовательские алгоритмы агрегации. Создание UDAF требует разработки более сложной логики и её интеграции в систему агрегирования Spark. В отличие от обычных UDF, UDAF имеет больше возможностей для оптимизации и использования в распределённых вычислениях.

Для работы с пользовательскими функциями важно учитывать вопросы масштабируемости и производительности. Неоптимизированные UDF могут привести к снижению скорости работы Spark, особенно при больших объёмах данных, поэтому их следует использовать с осторожностью и только в случаях, когда другие методы невозможны.

Применение Spark SQL в реальных сценариях анализа данных

В финансовом секторе Spark SQL применяется для обработки транзакционных данных в реальном времени. Он помогает быстро анализировать транзакции и выявлять аномалии, что важно для предотвращения мошенничества. Использование SQL-совместимых запросов позволяет аналитикам работать с привычной структурой данных, ускоряя процесс извлечения нужной информации.

В сфере электронной коммерции Spark SQL активно применяется для построения рекомендательных систем. Применяя SQL-запросы для анализа покупательских предпочтений, можно создавать персонализированные рекомендации. Например, запросы могут анализировать историю покупок пользователей и предсказывать вероятные товары для будущих покупок, повышая эффективность маркетинговых кампаний.

Другим примером является обработка данных из социальных сетей. В этой сфере Spark SQL используется для анализа больших потоков текстовых данных, например, для извлечения ключевых слов или анализа настроений. Запросы могут быстро агрегировать данные по регионам, времени публикации и контексту, что позволяет компаниям оперативно адаптировать свои стратегии взаимодействия с пользователями.

В производственных компаниях Spark SQL используется для мониторинга и анализа данных с сенсоров. Запросы могут обрабатывать потоковые данные с устройств в реальном времени, анализируя производственные параметры и обеспечивая быстрое реагирование на возможные сбои в процессе производства.

Кроме того, Spark SQL находит применение в медицине, например, для обработки данных клинических испытаний. Здесь запросы позволяют интегрировать информацию из разных источников, таких как лабораторные результаты и истории болезней, создавая единую базу для анализа и принятия решений по лечению.

Вопрос-ответ:

Что такое Spark SQL и как он используется в обработке данных?

Spark SQL — это компонент Apache Spark, который предоставляет интерфейс для работы с данными в виде SQL-запросов. Он позволяет пользователям интегрировать структурированные и полуструктурированные данные с возможностями обработки данных, предоставляемыми Spark. В отличие от традиционных систем, Spark SQL может работать с данными в разных форматах, таких как JSON, Parquet и Hive, что делает его удобным инструментом для работы с большими объемами данных. Spark SQL используется для выполнения сложных аналитических запросов и агрегирования данных, а также для интеграции с другими источниками данных, что помогает анализировать данные в реальном времени или с большой скоростью.

Каковы основные преимущества использования Spark SQL в обработке данных?

Одним из основных преимуществ Spark SQL является высокая скорость обработки данных благодаря использованию памяти и параллельной обработки на кластере. Это позволяет обрабатывать большие объемы данных гораздо быстрее, чем в традиционных системах управления базами данных. Кроме того, Spark SQL поддерживает выполнение SQL-запросов, что позволяет пользователям работать с данными, не углубляясь в детали программирования. Это открывает возможности для аналитиков данных и других специалистов, которые могут использовать привычный SQL для анализа больших наборов данных. Также Spark SQL поддерживает интеграцию с различными источниками данных, такими как Hadoop, Cassandra и HBase, что расширяет его применение в разных областях.

Какие типы данных поддерживает Spark SQL и как это влияет на его использование?

Spark SQL поддерживает разнообразные типы данных, включая строки, числа, булевы значения и более сложные типы, такие как массивы, карты и структуры. Это позволяет работать с различными источниками данных и форматами, такими как JSON, Parquet, Avro и другие. Способность работать с полуструктурированными данными, например, JSON, делает Spark SQL удобным для обработки данных, которые не всегда строго структурированы, что является распространенной задачей в реальных сценариях обработки данных. Возможность использовать такие типы данных увеличивает гибкость Spark SQL, позволяя пользователям быстро адаптировать решение под различные задачи в области аналитики и обработки больших данных.

Как можно интегрировать Spark SQL с другими инструментами для обработки данных?

Для интеграции Spark SQL с другими инструментами часто используются различные соединители и библиотеки, которые обеспечивают доступ к данным из внешних источников. Например, Spark SQL можно интегрировать с Hadoop для работы с данными в HDFS, с Hive для выполнения SQL-запросов к данным, хранящимся в Hive, или с базами данных, такими как MySQL, PostgreSQL и Cassandra, через JDBC или другие адаптеры. Благодаря такой гибкости, Spark SQL становится мощным инструментом для обработки данных в распределенных системах и позволяет легко работать с различными источниками данных. Использование этих интеграций открывает возможности для более сложных аналитических задач и позволяет обрабатывать данные из различных источников одновременно, что ускоряет принятие решений и анализ данных.