Работа с потоками в Node.js предоставляет разработчикам мощные инструменты для обработки данных, но одним из основных вызовов является эффективный выбор строк для дальнейшей обработки. Потоки позволяют работать с большими объемами информации, не загружая память, что особенно важно при обработке логов, больших файлов или API-ответов. Однако без правильного подхода к выбору строк процесс может стать неэффективным и трудозатратным.

Первое, на что стоит обратить внимание, это использование стримов с разделением данных на блоки. В Node.js потоки обычно обрабатывают данные поблочно, что позволяет эффективно управлять памятью. Для выборки строк важно учитывать, какой формат данных поступает в поток. Например, при обработке текстовых данных через поток readable данные часто приходят частями, и для их корректной обработки строки нужно вычленять по маркерам или регулярным выражениям.

Для работы с текстом в потоках можно использовать встроенные в Node.js модули, такие как stream.Transform или сторонние библиотеки, например, through2. Эти инструменты позволяют создать трансформации данных, при которых можно фильтровать или изменять строки в процессе их передачи по потоку. Применение таких решений минимизирует время задержки и эффективно снижает нагрузку на память при обработке большого объема данных.

Одним из ключевых моментов является выбор строки на основе условий, таких как наличие определенных подстрок или совпадений с регулярными выражениями. Для этого рекомендуется использовать оптимизированные алгоритмы поиска строк, которые сокращают количество операций и ускоряют обработку. В случае с большими данными такие операции должны быть высокоэффективными и учитывать особенности работы с потоками в асинхронной среде Node.js.

Как работать с потоками данных в Node.js для выборки строк

Для начала, важно понимать, как работают потоки в Node.js. Потоки бывают двух типов: читаемые (Readable) и записываемые (Writable). В случае выборки строк из файла или другого потока данных, основной интерес представляет поток чтения. Обычно для этого используется модуль fs.createReadStream(), который создает поток для чтения данных из файла.

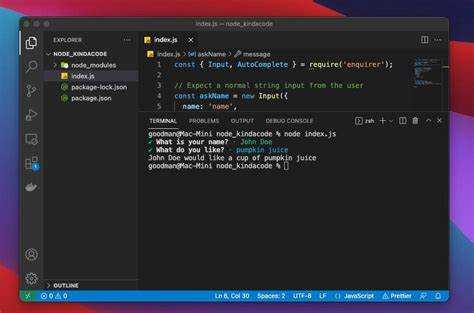

Для удобной выборки строк из потока данных часто применяется модуль readline. С помощью этого модуля можно считывать данные построчно, не загружая весь файл в память. Рассмотрим пример, как это реализовать:

const fs = require('fs');

const readline = require('readline');

const stream = fs.createReadStream('largeFile.txt');

const rl = readline.createInterface({

input: stream,

output: process.stdout,

terminal: false

});

rl.on('line', (line) => {

if (line.includes('нужная строка')) {

console.log(line);

}

});

В этом примере мы создаем поток для чтения файла largeFile.txt, используя fs.createReadStream. Затем, с помощью readline.createInterface, мы начинаем считывать файл построчно. В обработчике события 'line' можно добавить условие для выборки нужных строк, например, проверку на наличие подстроки. Это решение позволяет эффективно работать с большими файлами, не загружая их целиком в память.

Если требуется фильтровать строки по определенному условию, например, на основе регулярных выражений или других критериев, обработку можно дополнить. Например, для поиска строк, содержащих числовые значения, можно использовать следующий код:

rl.on('line', (line) => {

if (/\d+/.test(line)) {

console.log(line);

}

});

Для потоков, которые не являются файлами (например, данные поступают по сети), можно использовать те же подходы. Поток чтения данных из HTTP-ответа с использованием http.get() и дальнейшая обработка данных через readline будет аналогична. Важно помнить, что для потоков из сети необходимо учитывать асинхронность операций и возможность временных задержек.

Когда потоки данных из файла или другого источника обрабатываются с использованием readline, следует помнить, что это решение подходит для обработки последовательностей строк. Для более сложных операций с данными, например, извлечения частичных данных или агрегирования, возможно потребуется дополнительная логика для управления состоянием потока или буфером.

Наконец, следует учитывать, что выборка строк из потока требует грамотного управления потоками данных, чтобы избежать утечек памяти или переполнения буфера. Использование событий, таких как 'end' и 'close', позволяет корректно завершить обработку потока, гарантируя, что все ресурсы освобождены.

Какие методы фильтрации строк доступны в Node.js для потоков

В Node.js потоки используются для эффективной обработки больших объемов данных. Фильтрация строк в потоках позволяет выбрать только те данные, которые нужны, минимизируя использование памяти и повышая производительность. Для этого можно использовать несколько методов:

- Stream.pipe() с фильтрующими потоками:

Метод pipe() передает данные между потоками. Для фильтрации можно использовать фильтрующие потоки, такие как Transform. Это позволяет обработать данные по мере их поступления, исключая ненужные строки на лету.

const { Transform } = require('stream');

const filterStream = new Transform({

transform(chunk, encoding, callback) {

const line = chunk.toString();

if (line.includes('нужное слово')) {

this.push(chunk);

}

callback();

}

});

readableStream.pipe(filterStream).pipe(writableStream);Здесь данные фильтруются на уровне потока, не загружая весь набор данных в память.

- Использование модуля

split2для построчной фильтрации:

Модуль split2 разделяет входящий поток данных на строки. Это упрощает построчную фильтрацию, так как можно работать с отдельными строками, применяя необходимые фильтры.

const split = require('split2');

readableStream

.pipe(split())

.on('data', line => {

if (line.includes('ключевое слово')) {

writableStream.write(line + '\n');

}

});- Использование регулярных выражений:

Для более сложных условий фильтрации можно использовать регулярные выражения. Они позволяют гибко выбирать строки по шаблонам, например, для фильтрации строк с определенными форматами или структурой данных.

const regex = /^(?:\d{3}-\d{2}-\d{4})$/; // для фильтрации строк по шаблону SSN

const filterStream = new Transform({

transform(chunk, encoding, callback) {

const line = chunk.toString();

if (regex.test(line)) {

this.push(chunk);

}

callback();

}

});Этот метод особенно полезен при работе с текстовыми данными, где строки имеют четкую структуру или формат.

- Модуль

through2для фильтрации в реальном времени:

Модуль through2 позволяет создавать потоки для обработки данных в реальном времени. Это удобно для фильтрации данных, когда необходимо выполнять более сложные операции на каждой строке.

const through2 = require('through2');

const filterStream = through2.obj(function(chunk, enc, callback) {

const line = chunk.toString();

if (line.startsWith('important')) {

this.push(line);

}

callback();

});

readableStream.pipe(filterStream).pipe(writableStream);Этот метод позволяет реализовывать фильтрацию на основе сложных условий, таких как начало строки или сочетания нескольких признаков.

- Использование событий в потоках:

Кроме фильтрации данных внутри потоков, можно использовать события для фильтрации строк в процессе обработки. Например, с помощью события 'data' можно отслеживать строки, которые поступают в поток, и фильтровать их по нужным критериям.

readableStream.on('data', chunk => {

const line = chunk.toString();

if (line.includes('фильтр')) {

writableStream.write(line);

}

});Этот метод полезен, если требуется обработка данных до или после их передачи в поток.

Каждый из этих методов позволяет выбрать подходящий способ фильтрации в зависимости от специфики задачи, типа данных и производительности системы. Важно выбирать метод фильтрации, который лучше всего соответствует потребностям приложения и минимизирует нагрузку на память и процессор.

Как использовать регулярные выражения для выбора строк в потоке

В Node.js для обработки данных в потоке регулярные выражения (регэкспы) часто используются для фильтрации и поиска нужных строк. Это мощный инструмент, который позволяет эффективно работать с большими объемами текста, анализируя каждую строку или фрагмент данных по мере их поступления.

Для начала, чтобы применять регулярные выражения в потоках, можно использовать модуль stream в сочетании с методом RegExp.test() или String.match(). Основная задача – это отслеживать поступающие данные и проверять их на соответствие определённому шаблону.

Пример реализации с использованием потока и регулярных выражений:

const fs = require('fs');

const readline = require('readline');

const stream = fs.createReadStream('data.txt');

const rl = readline.createInterface({

input: stream,

output: process.stdout,

terminal: false

});

const regex = /error/i; // Регулярное выражение для поиска строк с ошибками

rl.on('line', (line) => {

if (regex.test(line)) {

console.log('Найдено совпадение:', line);

}

});

Важное преимущество использования регулярных выражений – это возможность динамически изменять критерии фильтрации. Например, для поиска строк, содержащих определённые шаблоны, можно модифицировать регулярное выражение на лету в зависимости от текущей ситуации. Это позволяет создавать гибкие и адаптируемые решения.

Однако важно помнить, что регулярные выражения могут быть неэффективными при работе с очень большими потоками данных. Избыточные или сложные шаблоны могут замедлить обработку. Чтобы минимизировать нагрузку, лучше избегать сложных и тяжёлых операций внутри событий потока.

Для повышения производительности также рекомендуется использовать асинхронные методы работы с потоками, такие как async/await, в сочетании с регулярными выражениями, чтобы избежать блокировки потока и обеспечивать плавную обработку данных.

Регулярные выражения особенно полезны в случаях, когда нужно фильтровать строки по сложным шаблонам или извлекать информацию из данных, поступающих в реальном времени. Важно тщательно тестировать регулярные выражения, чтобы избежать ненужных ошибок и замедлений при обработке больших объёмов данных.

Как управлять памятью при обработке строк в потоках Node.js

При обработке строк в потоках Node.js важно эффективно управлять памятью, особенно когда речь идет о больших объемах данных. Потоки позволяют работать с данными по частям, но без должного контроля над памятью можно столкнуться с утечками или значительным замедлением работы приложения.

Основные проблемы, с которыми можно столкнуться при обработке строк в потоках Node.js:

- Большие строки в памяти – когда данные поступают в виде больших строк, это может привести к избыточному использованию памяти.

- Утечки памяти – если строки не освобождаются должным образом, приложение будет накапливать ненужные данные в памяти.

- Фрагментация памяти – если строки часто перераспределяются, это может привести к фрагментации, что увеличивает нагрузку на сборщик мусора.

Для эффективного управления памятью в потоке можно использовать следующие подходы:

- Использование буферов вместо строк: В Node.js строки представляют собой неизменяемые объекты, что означает, что при каждой операции с ними создается новый объект в памяти. Буферы (Buffer) более эффективны, так как позволяют работать с данными в двоичном формате, минимизируя количество операций по перераспределению памяти.

- Потоковая обработка данных: Использование потоков позволяет работать с данными по частям, минимизируя потребление памяти. Вместо того чтобы загружать весь файл или данные в память, данные обрабатываются по мере поступления. Для этого стоит использовать классы потока

ReadableиWritableиз Node.js, чтобы читать и записывать данные кусками, контролируя количество данных, находящихся в памяти. - Ограничение размера буфера: Если необходимо обрабатывать данные в строках, важно ограничить размер буфера, чтобы избежать загрузки слишком большого объема данных в память. Например, можно использовать

highWaterMarkдля потоков, чтобы задать лимит на количество данных, которое может быть загружено в буфер. - Использование метода

sliceдля буферов: Когда нужно извлечь часть данных из потока, лучше использовать методsliceвместо создания новых строк. Это позволяет избегать дополнительных выделений памяти и уменьшить накладные расходы. - Удаление неиспользуемых данных: Важно помнить, что в Node.js сборщик мусора не всегда может эффективно освобождать память, связанную с большими строками. Рекомендуется явно освобождать ссылки на строки, когда они больше не нужны, чтобы сборщик мусора мог быстрее очистить память.

- Профилирование памяти: Для выявления проблем с памятью можно использовать инструменты профилирования, такие как

heapdumpилиnode --inspect, чтобы отслеживать использование памяти и вовремя находить утечки или перегрузку.

Соблюдая эти рекомендации, можно значительно снизить риск возникновения проблем с памятью при обработке строк в потоках Node.js, обеспечив более стабильную и эффективную работу приложения.

Какие библиотеки ускоряют выбор строк в потоках Node.js

При работе с большими объемами данных в потоках Node.js важно эффективно фильтровать и обрабатывать строки, чтобы минимизировать использование памяти и ускорить выполнение. Для этого существуют различные библиотеки, которые значительно ускоряют выбор строк в потоках, обеспечивая гибкость и высокую производительность.

1. streamifier

Библиотека streamifier позволяет преобразовывать данные из обычных строк в потоки, что делает обработку данных более эффективной. Это особенно полезно, когда необходимо работать с потоками, но данные изначально не имеют потоковой структуры. В сочетании с другими инструментами для работы с потоками, такими как stream.Transform, streamifier помогает ускорить процессы фильтрации и обработки строк, снижая нагрузку на память.

2. through2

through2 – это обертка вокруг стандартного потока Node.js, которая предоставляет удобный интерфейс для обработки данных. Используя through2, можно быстро фильтровать строки по определенным условиям, создавая потоки, которые трансформируют и фильтруют данные на лету. Библиотека поддерживает работу с асинхронными операциями, что позволяет эффективно обрабатывать строки в реальном времени без блокировки основного потока.

3. fast-csv

Для обработки CSV-данных в потоках популярной является библиотека fast-csv, которая предоставляет высокопроизводительное парсинг- и фильтрационное API. Она оптимизирована для работы с большими наборами данных, поддерживает как чтение, так и запись CSV файлов в потоках. Для выбора строк по определённым критериям fast-csv позволяет на лету фильтровать данные, минимизируя использование памяти.

4. split2

Библиотека split2 используется для разбиения данных на строки в потоке. Это полезно, когда необходимо обрабатывать большие объемы текстовых данных, например, при работе с журналами или логами. split2 эффективно разделяет входной поток на строки, позволяя фильтровать и обрабатывать данные быстрее, чем при использовании стандартных методов разбивки строк.

5. jsonstream

Если нужно работать с большими JSON-объектами, библиотека jsonstream может стать отличным решением. Она предоставляет методы для парсинга JSON-данных в потоке, позволяя извлекать строки или другие элементы объекта по мере их поступления. Это особенно эффективно при работе с большими объемами данных, где важно не загружать весь объект в память сразу, а обрабатывать его по частям.

6. lodash.stream

Библиотека lodash.stream предлагает функции для работы с потоками данных, интегрированные с возможностями фильтрации и трансформации, доступными в популярной библиотеке lodash. Она упрощает выбор строк на основе сложных условий и позволяет обрабатывать данные с высокой производительностью, избегая лишних вычислений. Это идеальный выбор для сложных операций фильтрации и сортировки в потоках.

7. rxjs

Если в проекте используется реактивное программирование, библиотека rxjs может значительно ускорить выбор строк в потоках. rxjs предоставляет мощные операторы для работы с асинхронными потоками данных, включая фильтрацию, маппинг и другие трансформации. Благодаря системе операторов можно эффективно обрабатывать данные по мере их поступления, не блокируя основной поток выполнения.

Каждая из этих библиотек предоставляет уникальные возможности для оптимизации процесса выбора строк в потоках Node.js. Выбор подходящей библиотеки зависит от характера данных, специфики задачи и требований к производительности.

Как правильно обрабатывать большие объемы строк в асинхронных потоках

Для эффективной обработки больших объемов строк в асинхронных потоках Node.js важно учитывать особенности работы с памятью и ресурсоемкость операций. Большие строки могут приводить к значительным затратам времени на их обработку, поэтому важно правильно организовать асинхронные операции, чтобы минимизировать время ожидания и не перегружать систему.

Первое, на что следует обратить внимание, это использование стримов. В Node.js стримы обеспечивают линейную обработку данных, что позволяет не загружать всю строку в память сразу, а обрабатывать её по частям. Для работы с текстовыми данными используйте модуль stream или специализированные пакеты, такие как readline, который позволяет читать данные построчно. Такой подход снижает нагрузку на память и ускоряет процесс, особенно при работе с файлами и сетевыми потоками.

Когда нужно обрабатывать большие строки в памяти, важно избегать их ненужного копирования. Используйте буферы, чтобы работать с данными напрямую, без создания дополнительных копий. В случае работы с большими строками или текстовыми файлами применяйте методы, которые позволяют читать данные частями, обрабатывая только необходимую информацию, а не всю строку целиком.

Другим важным аспектом является правильное использование асинхронных функций. Вместо того чтобы блокировать выполнение потока с помощью синхронных операций, всегда используйте асинхронные вызовы, такие как fs.readFile или stream.pipe, для чтения и записи данных. Это позволяет выполнять несколько операций одновременно, улучшая производительность при обработке больших объемов данных.

Не стоит забывать и про управление нагрузкой на процессор. При интенсивной обработке строк полезно добавлять задержки между операциями или использовать setImmediate или setTimeout, чтобы дать Node.js возможность обработать другие задачи в очереди событий. Это поможет избежать блокировки главного потока и обеспечит плавную работу асинхронных операций.

Важным аспектом является и обработка ошибок. Когда работаешь с большими данными, ошибки могут происходить на разных этапах – от чтения строки до её обработки и записи. Обязательно обрабатывайте ошибки с помощью try-catch и событий error в потоках. Это позволит избежать неожиданных сбоев и гарантировать, что поток будет корректно завершён в случае ошибки.

Таким образом, для эффективной обработки больших объемов строк в асинхронных потоках Node.js, используйте стримы, минимизируйте создание копий данных, применяйте асинхронные функции, контролируйте нагрузку на процессор и грамотно обрабатывайте ошибки. Это позволит значительно улучшить производительность и сделать вашу систему более масштабируемой.

Вопрос-ответ:

Как выбрать строки в потоке Node.js для обработки данных?

Для выбора строк в потоке Node.js важно использовать правильные методы работы с потоками. Один из самых популярных способов — это использование модулей, таких как `stream` или `readline`. Вы можете создать поток чтения из файла или другого источника данных, а затем отфильтровать или обработать строки в процессе их поступления. Например, с помощью модуля `readline` можно построчно читать данные и сразу же обрабатывать нужные строки. Также стоит учитывать асинхронность обработки данных в потоках, чтобы избежать блокировки выполнения.

Какие проблемы могут возникнуть при обработке данных в потоках Node.js?

Основные проблемы при обработке данных в потоках Node.js — это управление потоком данных и асинхронность. Если данные приходят слишком быстро, может возникнуть перегрузка памяти, так как потоки требуют аккуратной работы с буферами. Также важно правильно настроить обработку ошибок, поскольку при работе с внешними источниками (файлами, сетевыми запросами) могут возникать различные исключения, которые нужно корректно обрабатывать, чтобы не прерывать работу программы.

Какие методы можно использовать для обработки больших объёмов данных в потоках?

Для обработки больших объёмов данных в потоках рекомендуется использовать методы буферизации и оптимизации асинхронных операций. Одним из таких методов является использование потока в связке с `transform`-потоками, которые позволяют обрабатывать данные по частям, не загружая весь объём в память. Также важно следить за размером буфера, чтобы избежать его переполнения. Для обработки данных можно использовать библиотеки, такие как `stream-transform`, которые помогают организовать эффективную обработку данных в потоках с минимальными затратами памяти и времени.

Как выбрать строки в потоке Node.js для обработки данных?

Для выбора строк в потоке Node.js для дальнейшей обработки важно понимать, как работает потоковая обработка данных. В Node.js потоки обрабатывают данные по частям, что позволяет эффективно работать с большими объемами информации. Чтобы выбрать строки из потока, можно использовать такие методы, как `readableStream.on(‘data’)`, которые позволяют обрабатывать каждую часть данных по мере её поступления. Например, если вам нужно выбрать только строки, содержащие определённое слово, можно добавить проверку в обработчик события `data` и фильтровать нужные данные. Если данные поступают в формате строки, это можно делать с помощью регулярных выражений или методов строк, таких как `includes()` или `match()`, в зависимости от ваших задач.

Какие подходы есть для фильтрации данных в потоке Node.js, чтобы обрабатывать только нужные строки?

В Node.js существует несколько способов фильтрации данных в потоке. Если поток поступает как текст, один из самых простых способов — использовать событие `data` и применять методы строк, например, `match()` или `includes()`, для выбора строк, которые соответствуют определённым критериям. Можно также использовать встроенные библиотеки для работы с потоками, такие как `stream.Transform`, чтобы трансформировать или фильтровать данные по мере их поступления. Например, создание потока `Transform` позволяет модифицировать данные на лету, пропуская только те строки, которые подходят под заданные условия. В некоторых случаях полезно объединить эти методы с асинхронной обработкой, чтобы не блокировать основной поток выполнения.